A era dos Deepfakes: Desafios e estratégias para garantir a autenticidade e segurança na comunicação

A era dos Deepfakes: Desafios e estratégias para garantir a autenticidade e segurança na comunicação digital

(Estou repetindo o título, pois o campo não me permitiu digitá-lo por completo.)

A “realidade digital”, pelo visto, nunca mais será a mesma. Explorar o universo dos “deepfakes” é mergulhar em uma tecnologia capaz de transformar a aparência ou a voz de uma pessoa em vídeos com uma naturalidade impressionante. Em essência, os “deepfakes” são criados por algoritmos de inteligência artificial que manipulam imagens e sons, possibilitando a criação de conteúdos onde a verdade e a ilusão se entrelaçam - Fato curioso, ontem mesmo, eu estava fazendo um treinamento obrigatório na empresa onde trabalho sobre segurança da informação e as “deepfakes”. Apesar de fascinantes à primeira vista, esses recursos trazem sérios riscos: golpes, fraudes de identidade, desinformação e uma quebra na confiança dos nossos ambientes virtuais. Para o usuário comum, isso pode significar desde ser enganado em uma simples videochamada até implicações profundas na reputação e segurança pessoal.

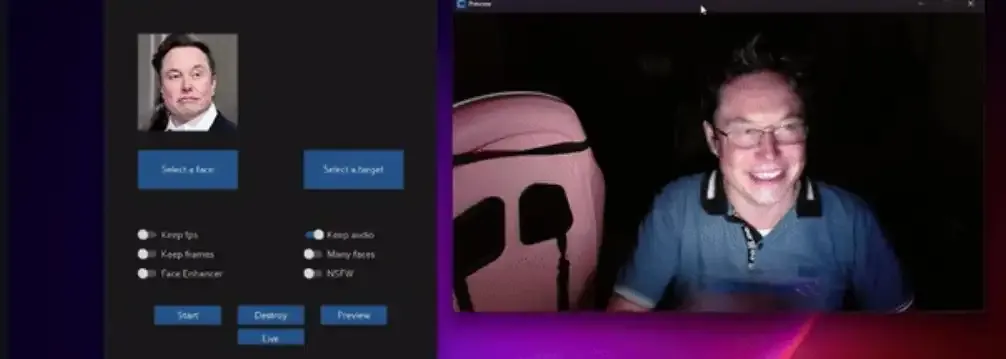

“Desconstrua sua percepção de realidade!”. Parece frase de filme de ficção, mas neste cenário, onde a visão já não garante veracidade, tecnologias inovadoras estão desafiando nossos conceitos básicos de autenticidade. Um exemplo marcante é o projeto "Deep-Live-Cam" (Repositório: https://github.com/hacksider/Deep-Live-Cam), que recentemente despontou no GitHub. O que torna essa iniciativa tão surpreendente e inquietante é sua capacidade de, a partir de uma única foto (SIM! Uma única foto.), assumir o rosto de qualquer pessoa durante uma videochamada – e tudo isso em tempo real, com um realismo surpreendente. Imagine: sem precisar de supercomputadores, sem edições elaboradas e sem os truques das produções hollywoodianas (ou bollywoodianas), a manipulação acontece de forma local e instantânea, transformando completamente a nossa definição de identidade em meio à comunicação digital.

Deepfake ao vivo: o que está em jogo?

Não estamos falando de vídeos pré-gravados cuidadosamente trabalhados. Esta é a manipulação ao vivo – onde a aparência se altera diante dos nossos olhos sem que ninguém perceba a troca sutil, mas poderosa. Essa evolução vem acompanhada de questões críticas:

- Professores, políticos, juízes, líderes religiosos, jornalistas, influenciadores: Para esses profissionais e/ou figuras religiosas, cuja credibilidade e autoridade são essenciais, a ameaça é ainda mais acentuada. Políticos, por exemplo, podem ser falsamente retratados em atos comprometedores, professores terem sua imagem de conhecimento questionada e jornalistas e/ou influenciadores verem sua reputação maculada por conteúdos manipulados. A verdadeira narrativa pode ser distorcida, confundindo o público e minando a confiança na informação.

- Entrevistas de emprego: Em processos seletivos, a confiança na identidade e na expressão autêntica dos candidatos pode ser comprometida. Imagine um candidato usando “deepfake” para assumir uma imagem mais profissional ou carismática: recrutadores podem ser levados a acreditar em uma versão idealizada, distorcendo as avaliações e potencialmente excluindo talentos reais em favor de aparências manipuladas.

- Serviços financeiros com verificação por vídeo: A autenticidade é a moeda de ouro em ambientes onde a segurança é fundamental. Agora, com o “deepfake” ao vivo, fraudes se tornam mais sofisticadas, abrindo brechas para que criminosos se passem por clientes, burlando sistemas de verificação e colocando em risco transações financeiras e dados sensíveis.

Lições para a era digital

O que aprendemos com essas inovações perturbadoras é que os métodos tradicionais de autenticação visual já não bastam. Nossa segurança não pode mais se fundamentar apenas em imagens, pois elas podem ser fabricadas com uma facilidade alarmante. Assim, é urgente promover uma educação robusta em inteligência artificial e cibersegurança – tanto para profissionais quanto para o usuário comum. Além disso, é necessário desenvolver sistemas de verificação que se adaptem a essa nova realidade, onde a linha entre o real e o artificial se torna cada vez mais tênue.

A pergunta não é mais: “Será que isso vai acontecer?” A indagação atual é: o que você está fazendo para se proteger quando essa tecnologia já está batendo à sua porta?

Encare a nova realidade

A evolução tecnológica é incessante e, com ela, também deve crescer a nossa responsabilidade. Se não nos prepararmos, correremos o risco não de sermos dominados por uma IA desenfreada, mas de ver a própria confiança – a base da comunicação e da convivência – se desintegrar. Já passou da hora de repensar como nos identificamos, como validamos a informação e, principalmente, como educamos a nossa sociedade para navegar por essas “águas digitais turbulentas”.

A transformação já começou há algum tempo. Cabe a nós decidir se seremos meros espectadores ou se adotaremos as medidas necessárias para proteger nossa identidade e a integridade do mundo digital. Agora, reflita e questione: qual é o MEU plano para enfrentar esse novo desafio? Em um mundo onde o real e o artificial se fundem, adaptar-se é a única forma de manter a confiança em nossas interações digitais.