Atenção! Prompt não é comando: é estratégia. Aprenda a usar a IA Generativa como um expert.

- #IA Generativa

Preste atenção para aprender sobre IA generativa

O artigo Attention is All You Need (2017) trouxe uma revolução para a área de Inteligência Artificial Generativa. A proposta era apresentar uma nova arquitetura de redes que era mais simples e baseada em mecanismos de atenção, evoluindo os tradicionais modelos baseados em redes recorrentes (RNNs) e convolucionais (CNNs).

A grande revolução trazida pelo artigo, que permitiu ganhos significativos em paralelização, velocidade de treinamento e desempenho, veio com a ideia de atenção interna (self attention). Os transformers permitiram que o modelo fizesse sempre uma avaliação de cada palavra em relação às demais no mesmo contexto, assim, chegar ao sentido de cada palavra e daquelas ao seu redor, feitas simultaneamente pelas camadas de atenção multi-cabeça (multi-head attention) e pelo uso de codificações posicionais (positional encoding) para entender a posição de cada palavra, foram exponencialmente melhorados.

Por exemplo: o uso de transformers permitiu que o computador ao ler a frase “A menina viu o cachorro com o telescópio”, entendesse que estamos falando de uma menina que usando um telescópio conseguiu ver um cachorro e não que ela viu o doguinho carregando um telescópio.

E eu com isso? O modelo de transformers, como toda revolução, rompeu mais que uma arquitetura de Inteligência Artificial, ele abriu infinitas possibilidades de aplicação dos modelos de Inteligência Artificial, justamente por possibilitar uma maior acurácia dos modelos, com significativa diminuição no tempo de treinamento. E um desses efeitos foi a explosão recente dos LLMs que passaram a estar presentes na vida de todos.

Ok, mas o que são os LLMs?

LLMs: Computadores falando como gente

Conforme apresenta Kumar (2024), os Large Language Model (Modelo de Linguagem de Grande Escala) explodiram em anos recentes graças ao uso dos Transformers, que possibilitaram que aprendessem representações universais da linguagem a partir de extensos conjuntos de dados, mas com um custo e um tempo muito reduzidos e com o ganho adicional de acurácia de seus resultados em relação aos modelos anteriores de recorrência e convolução.

Por isso, hoje conseguimos apresentar prompts a computadores utilizando linguagem natural e obtemos resultados com grande acurácia em diferentes formatações e formatos.

Opa, por que complicar? Isso quer dizer que agora podemos falar com as máquinas utilizando nossa linguagem nativa, inclusive sem se preocupar com o idioma que nos comunicamos, pois a maioria dos modelos são multi-linguísticos, e conseguimos que elas nos respondam do jeito que precisamos: com um relatório, uma poesia, uma música (só a letra ou com arranjos e voz), uma arte, um slogan ou qualquer outra coisa que nossa imaginação ou necessidade apresentem.

Mas, claro, como todo ente dotado de capacidades linguísticas, a resposta será proporcional e diretamente relacionada à forma como o comando é apresentado. Por isso é importante conhecer sobre Engenharia de Prompt.

Que conversa é essa de Engenharia de Prompt? Tem jeito certo de falar com máquina?

Aqui resgatamos um conceito apresentado na definição inicial, “Prompt”. Ele diz respeito à mensagem que é apresentada à Inteligência Artificial com nossa necessidade para que ele apresente sua resposta.

Não estamos falando em transformar nossos comandos em linguagem de máquina para que a IA entenda com maior precisão o que queremos. Com a comunicação em linguagem natural entre IA e humano, devemos elaborar muito bem o pedido a ser feito de modo a otimizar os resultados que serão apresentados pelas máquinas.

O prompt é um conjunto de informações que o usuário fornece para guiar o modelo de linguagem a gerar uma resposta. Funciona como uma instrução ou pergunta para que o modelo entenda a necessidade do usuário e possa gerar uma resposta adequada.

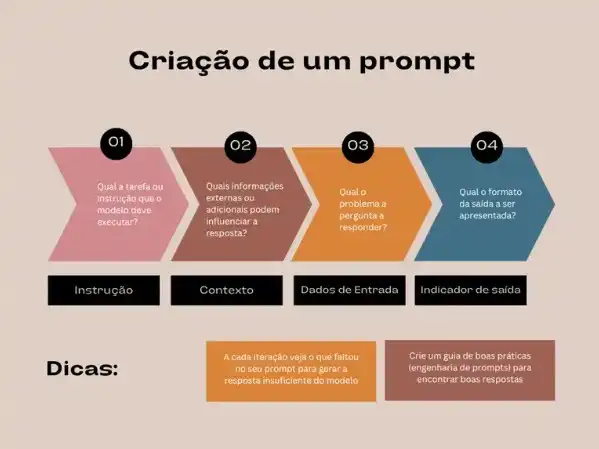

Segundo o Prompt Engineering Guide - PEG (2025), um prompt é composto dos seguintes elementos:

- instrução: determina qual tarefa ou instrução específica que o modelo deve executar.

- dados de entrada: qual o problema ou pergunta o modelo deve responder.

- contexto: envolve informações externas ou contexto adicional para direcionar o modelo para melhores respostas. Uma estratégia é apresentar exemplos para que o modelo entenda a resposta desejada.

- indicador de saída: indica o tipo ou formato no qual o modelo deve apresentar sua resposta. É interessante apresentar uma sugestão de como a resposta poderia ser apresentada. Também podem ser apresentadas restrições para a resposta, como máximo de linhas ou termos que não devem ser incluídos.

Escrever um bom prompt é essencial para obter os melhores resultados. Você poderia simplesmente chegar para a IA e pedir, por exemplo:

Crie para mim uma apostila tratando dos seguintes tópicos:

- O que é um LLM e como funciona

- Princípios da Engenharia de Prompt

- O que é RAG e como usar

- Como reduzir alucinações em GenAI

Você teria uma resposta de alguns parágrafos tratando de maneira genérica e de maneira encadeada os conceitos acima. Agora, veja um exemplo de um prompt estruturado para criar uma apostila mais estruturada e completa sobre os tópicos acima:

(Instrução)

Você é um especialista em Inteligência Artificial e Educação Digital. Sua tarefa é criar uma apostila introdutória e didática sobre conceitos fundamentais de IA generativa.

(Dados de entrada)

A apostila deve abordar, em seções separadas e bem explicadas, os seguintes temas:

- O que é um LLM e como funciona

- Princípios da Engenharia de Prompt

- O que é RAG e como usar

- Como reduzir alucinações em GenAI

(Contexto)

A apostila será utilizada em um curso de formação para servidores públicos iniciantes em IA. O tom deve ser educativo, claro e acessível, evitando jargões técnicos complexos e explicando cada conceito com exemplos práticos.

Inclua uma introdução geral, exercícios simples ao final de cada seção e uma conclusão que integre os temas.

Inclua referências externas com os autores principais ou estudos mais recentes e interessantes de cada tema.

(Indicador de saída)

Apresente o resultado em formato HTML, SCSS e JavaScript, para criação de uma landing page com os títulos em cards e o conteúdo em modais, com:

- Títulos e subtítulos hierárquicos;

- Destaques em negrito para termos-chave;

- Listas e exemplos formatados;

- Cada seção iniciando com uma breve definição e seguida de explicações detalhadas;

- Links para referências e conceitos importantes.

(Restrições)

- Evite usar linguagem excessivamente técnica.

- O texto deve ter no máximo 5 páginas equivalentes.

- Inclua referências preferencialmente em português ou com os autores originais em inglês, evitando referências em outros idiomas.

O prompt seguindo essa estrutura irá gerar com certeza uma resposta muito mais completa e adequada para o objetivo de capacitar as pessoas nos temas propostos.

Uma dica importante: o processo de criação de prompts é iterativo! Isso significa que você deve interagir com a máquina, refinando o prompt a cada resposta. Ou seja, é essencial analisar a saída e ajustar o próximo prompt para melhorar o resultado.

Mas nem tudo são flores ou previsões 100% acuradas - RAG e estratégias para melhorar as respostas e diminuir alucinações e imprecisões

Conforme pontua LEWIS e cols. (2020), os primeiros modelos de IA generativa eram treinados a partir de quantidades massivas de dados e realizavam suas tarefas sem acessar bases de dados externas, funcionando com uma base de conhecimento implícita parametrizada. Já os modelos híbridos mais recentes combinam memória paramétrica com memórias não paramétricas (ou seja, baseadas em recuperação), permitindo gerar respostas mais acuradas e sanar parte das famosas alucinações.

Os modelos retrieval-augmented generation (RAG - Geração aumentada por recuperação) apresentados no estudo mostraram melhoras significativas na qualidade das respostas obtidas e em especial na diminuição das alucinações, que permitem aplicações práticas muito interessantes como responder perguntas a partir de um índice médico ou ajudarem as pessoas a otimizarem seus trabalhos.

Claro que os autores realçam a importância da conferência, pois mesmo esses modelos de consulta com recuperação não estão totalmente livres de falhas, pois inclusive, as fontes de dados recuperadas podem não ser totalmente acuradas.

Além de modelos cada vez mais inteligentes, a construção de um bom prompt é essencial para obter a melhor resposta possível, inclusive diminuindo o risco de alucinações e respostas imprecisas. Mas como faço isso?

- O objetivo do prompt, ou seja, o que ele precisa fazer, deve ser clara e objetivamente definido. Quanto melhor você disser para a IA o que você quer, melhor será a resposta que terá.

- É importante incluir contexto relevante como para quem o produto será direcionado, qual a finalidade da resposta e a descrição precisa de como o resultado deve ser apresentado.

- Construa o prompt seguindo os blocos instrução, contexto, dados de entrada e dados de saída, para que seja mais completo e estruturado.

- Apresente, sempre que possível, exemplos para orientar a construção da resposta.

- Sempre que relevantes, apresente restrições e outras condições essenciais para a resposta.

- Para evitar alucinações, peça referências ou justificativas, delimite o escopo da pesquisa e da resposta e, quando possível, utilize modelos com RAG para gerar respostas validadas em fontes de dados atualizadas.

- Analisar a resposta apresentada de maneira crítica é essencial para evitar erros e alucinações e sempre que desconfiar da resposta apresentada pela IA, peça a ela que verifique suas referências e valide a resposta apresentada.

Mas para que tanto trabalho, já que serei substituído pela IA?

Essa é uma das fake news mais comuns e que precisa ser combatida. A IA generativa não surgiu para eliminar a força de trabalho humana, mas para potencializar as capacidades humanas naquilo que lhes é próprio.

Conforme afirma Kumar (2024) os LLMs revolucionaram tanto as ciências exatas quanto as ciências sociais, acelerando pesquisas, aprimorando processos de descoberta e fomentando a colaboração interdisciplinar.

A IA veio para apoiar a execução de tarefas complexas, sem substituir o papel humano de decidir qual caminho seguir, de ir além do óbvio, de analisar dados e buscar conexões que ultrapassam as evidências imediatas, identificando possibilidades muitas vezes desconectadas da realidade atual.

Um exemplo é a prática médica: em alguns casos, a IA pode chegar a um diagnóstico mais rápido e preciso que um médico, com base em exames e evidências clínicas. No entanto, ela não possui a capacidade de compreender nuances psicossociais, acolher o paciente diante de um diagnóstico ou tratamento, nem perceber fatores ambientais ou escolhas pessoais que não aparecem em exames, mas que impactam diretamente no prognóstico e na recuperação.

A IA não veio para acabar com o trabalho humano, mas para permitir que as pessoas aproveitem os recursos tecnológicos para realizar determinadas tarefas e agregar aos resultados o máximo de suas capacidades intrinsecamente humanas.

Para potencializar seu trabalho, é essencial saber se comunicar de forma eficiente com a IA generativa. Dominar estratégias de engenharia de prompt para diminuir imprecisões e alucinações e otimizar os resultados obtidos com o suporte das inteligências artificiais será uma das chaves para o sucesso profissional nos próximos anos.

Referências

- KUMAR, P. (2024). Large language models (LLMs): survey, technical frameworks, and future challenges. Artif Intell Rev 57, 260 (2024). https://doi.org/10.1007/s10462-024-10888-y. Disponível em: https://link.springer.com/article/10.1007/s10462-024-10888-y. Acesso em: 3 de novembro de 2025.

- GUIA DE ENGENHARIA DE PROMPT (2025). Disponível em https://www.promptingguide.ai/pt. Acesso em: 3 de novembro de 2025.

- LEWIS, Patrick; PEREZ, Ethan; PIKTUS, Aleksandra; PETRONI, Fabio; KARPUKHIN, Vladimir; GOYAL, Naman; KÜTTLER, Heinrich; LEWIS, Mike; YIH, Wen-tau; ROCKTÄSCHEL, Tim; RIEDEL, Sebastian; KIELA, Douwe (2020). Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks. arXiv preprint arXiv:2005.11401, 2020. Disponível em: https://arxiv.org/abs/2005.11401. Acesso em: 03 nov. 2025

- VASWANI, Ashish; SHAZEER, Noam; PARMAR, Niki; USZKOREIT, Jakob; JONES, Llion; GOMEZ, Aidan N.; KAISER, Łukasz; POLOSUKHIN, Illia. Attention is all you need. arXiv:1706.03762, 2017. Disponível em: https://arxiv.org/abs/1706.03762. Acesso em: 3 de novembro de 2025.