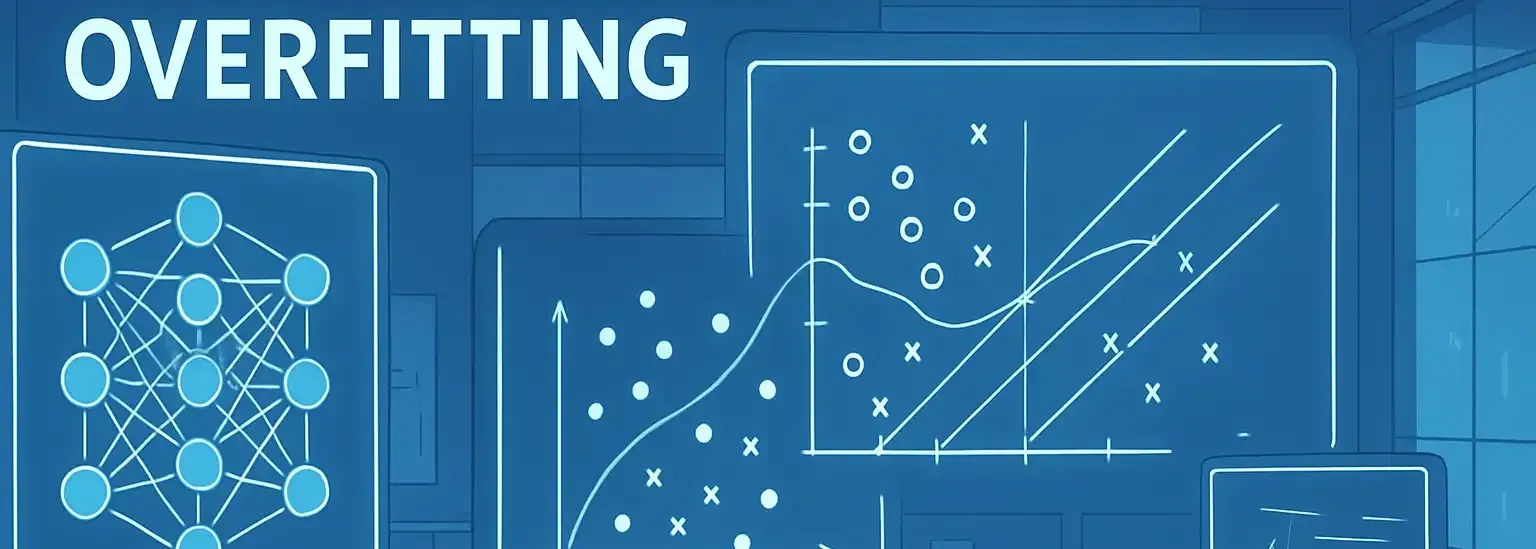

Dominando o Overfitting: Por Que Suas Redes Neurais e SVMs Precisam Ser Treinadas com Cuidado?

- #Machine Learning

- #Inteligência Artificial (IA)

Você já investiu horas ajustando modelos de machine learning, mas percebeu que, embora seu algoritmo tenha desempenho espetacular nos dados de treino, os resultados nos dados novos são frustrantemente baixos? Bem-vindo ao mundo do overfitting, um dos desafios mais intrigantes (e traiçoeiros) do aprendizado de máquina! Neste artigo, vamos explorar o que é overfitting, entender por que acontece e discutir as nuances desse fenômeno em Redes Neurais Artificiais (RNA) e Máquinas de Vetores de Suporte (SVM).

O que é Overfitting?

Overfitting, ou sobreajuste, ocorre quando um modelo aprende tão bem os detalhes e ruídos dos dados de treinamento que perde a capacidade de generalizar para novos dados. É como um estudante que, ao decorar todas as respostas de uma prova antiga, se sai muito bem nela, mas fracassa diante de questões inéditas. Um modelo overfitted apresenta alta precisão no conjunto de treinamento, mas fraco desempenho no conjunto de teste ou em dados novos, tornando suas previsões pouco confiáveis.

Por que ocorre?

- Complexidade excessiva do modelo (muitos parâmetros ou camadas).

- Pouca quantidade de dados para treino, levando o modelo a decorar padrões específicos.

- Ausência ou mau uso de técnicas de regularização.

Overfitting em Redes Neurais Artificiais (RNA)

Nas RNA, o overfitting se manifesta principalmente quando o modelo possui muitas camadas e neurônios, tornando-se capaz de "memorizar" exemplos específicos do treino. Fatores que agravam o overfitting em RNA incluem:

- Arquiteturas muito profundas ou largas: quanto mais complexa a rede, maior a chance de aprender detalhes irrelevantes.

- Poucos dados ou ausência de regularização: técnicas como dropout, early stopping e L2 regularization são essenciais para evitar o sobreajuste.

- Tempo excessivo de treinamento: treinar a rede por muito tempo pode fazer com que ela acabe aprendendo ruídos e exceções, ao invés de padrões gerais.

Sintomas

- Diferença grande entre as métricas de desempenho do treino e do teste.

- Erro de treinamento muito baixo, mas erro de validação/teste alto.

Overfitting em SVM (Máquinas de Vetores de Suporte)

Apesar de as SVM serem, por padrão, modelos “menos flexíveis” que as RNA, elas também podem sofrer overfitting, especialmente quando o kernel e seus hiperparâmetros não são bem escolhidos.

- Configuração do Kernel: kernels muito complexos, como polinômios de grau elevado ou RBF com gama alta, podem fazer a SVM criar limites de decisão que se ajustam demais aos dados de treino.

- Valor do parâmetro C: valores muito altos de C podem penalizar erros excessivamente e fazer o modelo construir fronteiras muito "justas" em relação aos dados de treinamento.

- Pouca generalização: assim como nas RNA, o modelo SVM vai se sair mal em dados fora da amostra se estiver overfitted.

Sintomas

- Fronteiras de decisão complexas e pouco intuitivas.

- Excelente desempenho em treino e baixa performance em teste, especialmente ao usar kernels muito sofisticados.