Entendendo o Funcionamento Interno de Modelos LLM

- #Machine Learning

- #Lógica de Programação

- #Gerenciamento de Pacotes

- #Data

- #Python

- #IA Generativa

- #DevSecOps

- #Inteligência Artificial (IA)

- #Engenharia de Prompt

- #API

- #Segurança da Informação

- #Integração

- #LLMs

Funcionamento Base sem Treinamento

O uso de prompt é uma técnica fundamental para direcionar o comportamento de um LLM. [1] [2] [3]

Em vez de depender exclusivamente de um treinamento massivo, podemos fornecer um prompt cuidadosamente elaborado para guiar a IA na tarefa desejada.

Imagine um LLM sem nenhum treinamento prévio. Ele é essencialmente uma "folha em branco", mas com a capacidade de processar texto. Ao utilizar de um comando como "Traduza a seguinte frase para o francês: 'Olá, mundo!'", estamos fornecendo ao modelo tanto a tarefa, quanto um exemplo do tipo de entrada que ele deve esperar. [1]

O modelo, então, analisa o comando do usuário e, com base em sua arquitetura interna de prompts, tenta encontrar padrões e relações entre as palavras e a tarefa solicitada. Mesmo sem treinamento, ele pode ser capaz de gerar uma tradução razoável, embora a qualidade dependa da complexidade da tarefa e da capacidade do modelo. [3]

Interpretação de Textos e MCP Wrapper IBM

A interpretação de textos por um LLM envolve a decomposição da linguagem em unidades menores, como palavras, frases e até mesmo caracteres. Cada unidade é então convertida em uma representação numérica, geralmente um vetor, que captura o significado e o contexto da unidade. [5] [6]

O que é o MCP?

O Model Context Protocol (MCP) é um padrão aberto que define como os grandes modelos de linguagem (LLMs) podem interagir com o mundo externo, como bases de dados, APIs e outros sistemas. Desenvolvido pela Anthropic, ele resolve as limitações de conhecimento fixo dos LLMs, permitindo que eles acessem dados em tempo real e executem ações. [4] [5]

Funções do wrapper MCP da IBM (ContextForge):

O ContextForge atua como um intermediário inteligente e robusto para a geração do contexto. Suas principais funções incluem [5] :

- Virtualização de protocolo: Ele pode converter APIs REST e gRPC existentes em servidores compatíveis com o projeto, o que permite que as empresas integrem rapidamente seus sistemas legados ao ecossistema de IA sem refatorações custosas.

- Federação de serviços: O gateway pode federar diversos serviços MCP e REST em um único ponto de acesso, simplificando a descoberta e o gerenciamento de ferramentas para os agentes de IA.

- Centralização de segurança: Ele oferece recursos de segurança unificados, como autenticação JWT e controle de acesso.

- Observabilidade e monitoramento: O ContextForge fornece recursos para rastrear chamadas de ferramentas, monitorar o uso e garantir a estabilidade das operações dos agentes.

- Conversão de protocolo: O gateway converte entre diferentes modos de transporte de dados (como STDIO, SSE e HTTP), tornando-o flexível para diferentes cenários de implantação.

- Gerenciamento de ferramentas: Permite encapsular comandos de linha de comando ou APIs existentes como "ferramentas" que os agentes de IA podem invocar por meio de suas regras.

No contexto de um LLM, o MCP é usado para aprender as relações complexas entre as palavras e frases em um texto. A primeira camada do MCP recebe os vetores de entrada (representações numéricas das palavras), e as camadas subsequentes transformam esses vetores em representações mais abstratas que capturam o significado e o contexto do texto. [4] [5] [6]

Modelo de Pensamento Estatístico e Processamento de Dados

O "pensamento" de um LLM é fundamentalmente estatístico. Ele não "entende" o significado das palavras da mesma forma que um humano, mas sim aprende a prever a probabilidade de uma palavra aparecer em um determinado contexto. [6] [7]

Durante o treinamento, o LLM é exposto a grandes quantidades de texto e aprende a identificar padrões e relações estatísticas entre as palavras. Por exemplo, ele pode aprender que a palavra "gato" é frequentemente seguida por palavras como "mia", "dorme" ou "come".

Quando o LLM recebe um prompt, ele usa essas probabilidades para gerar texto. Ele começa com o prompt de treinamento e, em seguida, seleciona a palavra mais provável de aparecer em seguida, com base no contexto do conteúdo e nas probabilidades aprendidas durante o treinamento. Ele repete esse processo, palavra por palavra, até gerar um texto completo.

O processamento de dados em um LLM envolve várias etapas [5] [6] [7]:

- Tokenização: O texto é dividido em unidades menores, como palavras ou subpalavras.

- Embedding: Cada token é convertido em um vetor numérico que representa seu significado.

- Processamento em Camadas: Os vetores são processados através de várias camadas de redes neurais para capturar relações complexas.

- Geração de Texto: Com base no processamento e união com o prompt de treinamento, o modelo prevê a próxima palavra mais provável e a adiciona ao texto gerado.

Programando um LLM com Base Lógica

Programar um LLM com uma base lógica consistente é um desafio complexo. A abordagem tradicional de treinamento de LLMs se concentra em aprender padrões estatísticos a partir de grandes quantidades de dados, o que pode levar a resultados impressionantes, mas também a inconsistências lógicas e erros factuais. [8] [9] [10]

Uma abordagem para incorporar lógica em um LLM é usar técnicas de raciocínio simbólico [9]. Isso envolve representar o conhecimento em um formato lógico de prompts, como regras ou fatos, e usar um motor de inferência para raciocinar sobre esse conhecimento.

Por exemplo, podemos fornecer ao LLM um conjunto de regras lógicas sobre relações familiares, como "Se A é pai de B e B é pai de C, então A é avô de C". Em seguida, podemos fazer perguntas ao LLM sobre relações familiares e esperar que ele use as regras lógicas para responder corretamente.

No entanto, integrar raciocínio simbólico com LLMs baseados em redes neurais é um desafio. As redes neurais são boas em aprender padrões estatísticos, mas não são inerentemente boas em raciocínio lógico. Uma abordagem promissora é combinar as duas técnicas, usando redes neurais para aprender representações de conhecimento e motores de inferência para raciocinar sobre essas representações.

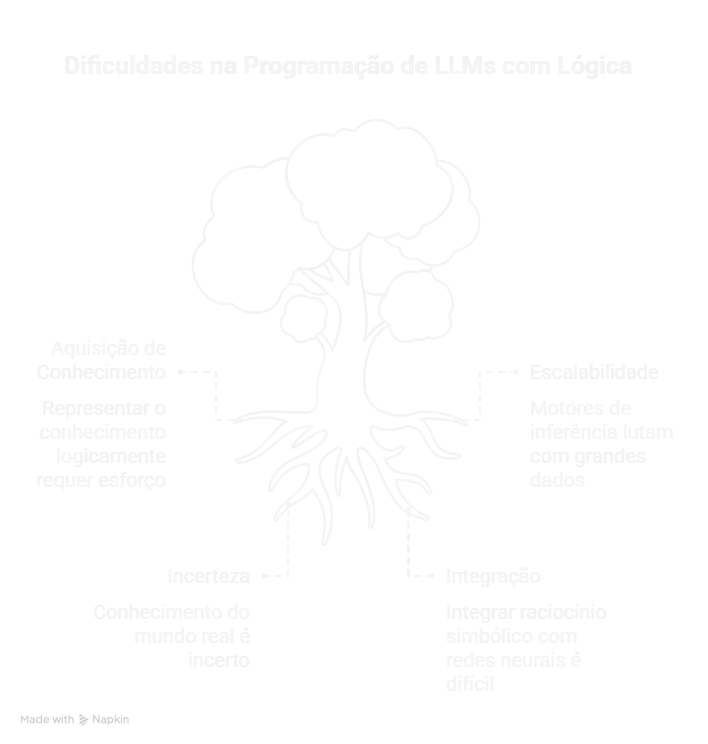

Dificuldades na Programação com Lógica de Prompts

Existem várias dificuldades em programar um LLM com uma base lógica [8] [9] [10]:

- Aquisição de Conhecimento: Representar o conhecimento em um formato lógico requer um esforço significativo de engenharia de conhecimento.

- Escalabilidade: Os motores de inferência podem ter dificuldades em lidar com grandes quantidades de conhecimento.

- Incerteza: O conhecimento do mundo real é frequentemente incerto e incompleto, o que dificulta a representação em um formato lógico.

- Integração: Integrar raciocínio simbólico com redes neurais é um desafio técnico.

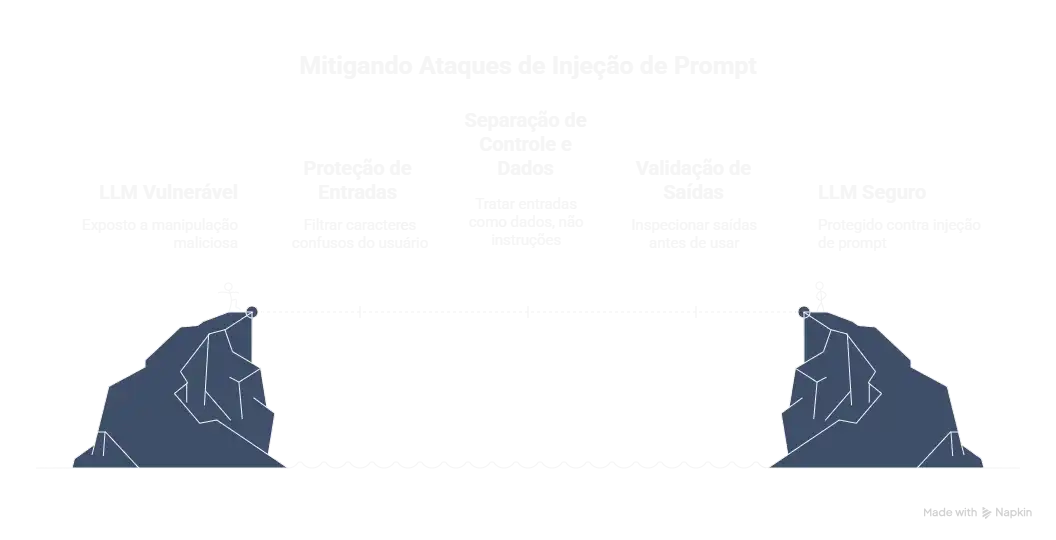

Ataques de injeção de prompt

Um ataque de injeção de prompt acontece quando um invasor insere instruções maliciosas em uma entrada para um LLM, forçando o modelo a executar intenções não autorizadas, em vez das originais. Isso pode causar roubo de dados, divulgação de informações confidenciais, geração de desinformação, execução de comandos perigosos ou tomada de controle de sistemas, e é considerado a principal vulnerabilidade de segurança em aplicações de LLMs. [1] [3] [4] [11] [12] [13]

Funcionamento dos ataques [11] [12] [13]:

- Problema base: A vulnerabilidade decorre da impossibilidade de separar o "controle" (regras e instruções do sistema) e os "dados" (entrada do usuário) em um único prompt.

- Engenharia social: É um tipo de engenharia, pois o ataque manipula a confiança no sistema para forçar ele a agir contra suas próprias instruções e regras.

- Exemplos de injeção:

- Direta: O invasor insere a instrução maliciosa diretamente no prompt do sistema.

- Indireta: O conteúdo malicioso vem de fontes externas, como um site ou documento, que é processado pelo LLM e altera seu comportamento.

Principais perigos:

- Roubo de dados: O LLM pode revelar dados confidenciais ou segredos do sistema.

- Manipulação de conteúdo: O modelo pode gerar informações falsas, tendenciosas ou conteúdo não autorizado.

- Ações não autorizadas: O invasor pode fazer o LLM executar comandos perigosos em sistemas conectados, como executar malware ou manipular processos críticos.

Como se prevenir [11] [13]:

- Proteção de entradas: Implementar filtros para evitar que usuários insiram caracteres que poderiam confundir o LLM.

- Separar controle e dados de entrada: Implementar mecanismos que tratem as entradas dos usuários como dados, não como instruções.

- Não confiar nas saídas: Tratar todas as saídas do LLM como potencialmente maliciosas e inspecioná-las antes de usá-las em sistemas conectados.

- Utilizar o menor privilégio: Ao chamar serviços externos, utilizar modelos de privilégio de apenas leitura, incapacitando assim de realizar mudanças no sistema.

Tempo de Processamento e Tamanho dos Dados

O tempo de processamento de um LLM depende de vários fatores, incluindo [6] [7]:

- Tamanho do Modelo: Modelos maiores com mais parâmetros geralmente levam mais tempo para processar.

- Complexidade da Tarefa: Tarefas mais complexas, como tradução ou resumo, geralmente levam mais tempo do que tarefas mais simples, como preenchimento de lacunas.

- Tamanho da Entrada: Entradas maiores como comandos de perguntas mais longos e arquivos com muitos dados geralmente levam mais tempo para processar.

- Hardware: O hardware utilizado afeta significativamente o tempo de processamento.

Em geral, o tempo de processamento aumenta com o tamanho do modelo e a complexidade da tarefa. Para tarefas que exigem respostas rápidas, é importante otimizar o modelo e o hardware. [6] [7]

Em resumo, os LLMs são ferramentas poderosas, mas complexas. Compreender seu funcionamento interno, desde a injeção de prompts até o processamento estatístico de dados, é fundamental para utilizá-los de forma eficaz e para enfrentar os desafios na programação de LLMs com uma base lógica consistente.

Referências:

[1] P. Sahoo, A. K. Singh, S. Saha, V. Jain, S. Mondal and A. Chadha, “A Systematic Survey of Prompt Engineering in Large Language Models: Techniques and Applications,” arXiv preprint arXiv:2402.07927, Feb. 2024. [Online]. Available: https://arxiv.org/abs/2402.07927. Accessed: Oct. 29, 2025.

[2] “Prompt engineering is the process of structuring or crafting an instruction in order to produce better outputs from a generative artificial intelligence (AI) model,” Wikipedia, [Online]. Available: https://en.wikipedia.org/wiki/Prompt_engineering. Accessed: Oct. 29, 2025.

[3] Google Cloud, “What is Prompt Engineering?”, Google Cloud Documentation, [Online]. Available: https://cloud.google.com/discover/what-is-prompt-engineering. Accessed: Oct. 29, 2025.

[4] Anthropic, “Introducing the Model Context Protocol,” Anthropic Newsroom, Nov. 2024. [Online]. Available: https://www.anthropic.com/news/model-context-protocol. Accessed: Oct. 29, 2025.

[5] A. Gutowska, “What is the Model Context Protocol (MCP)?,” IBM Think, [Online]. Available: https://www.ibm.com/think/topics/model-context-protocol. Accessed: Oct. 29, 2025.

[6] D. Haslett, “Tokenization Changes Meaning in Large Language Models,” Computational Linguistics, vol. 51, no. 3, pp. 785–792, 2025. [Online]. Available: https://direct.mit.edu/coli/article/51/3/785/128327/Tokenization-Changes-Meaning-in-Large-Language. Accessed: Oct. 29, 2025.

[7] S. Trott, “Tokenization in Large Language Models, Explained,” Substack Blog, 2025. [Online]. Available: https://seantrott.substack.com/p/tokenization-in-large-language-models. Accessed: Oct. 29, 2025.

[8] M. Fang, “Large Language Models Are Neurosymbolic Reasoners,” arXiv preprint arXiv:2401.09334, 2024. [Online]. Available: https://arxiv.org/abs/2401.09334. Accessed: Oct. 29, 2025.

[9] X.-W. Yang, J.-J. Shao, L.-Z. Guo, B.-W. Zhang, Z. Zhou, L.-H. Jia, W.-Z. Dai and Y. Li, “Neuro-Symbolic Artificial Intelligence: Towards Improving the Reasoning Abilities of Large Language Models,” arXiv preprint arXiv:2508.13678, 2025. [Online]. Available: https://arxiv.org/abs/2508.13678. Accessed: Oct. 29, 2025.

[10] U. Nawaz, T. Hussain, M. Raza, and S. Ahmed, “A Review of Neuro-Symbolic AI Integrating Reasoning and Learning,” Artificial Intelligence Review, 2025. [Online]. Available: https://www.sciencedirect.com/science/article/pii/S2667305325000675. Accessed: Oct. 29, 2025.

[11] IBM, “What is a Prompt Injection Attack?”, IBM Think, [Online]. Available: https://www.ibm.com/think/topics/prompt-injection. Accessed: Oct. 29, 2025.

[12] HiddenLayer, “Prompt Injection Attacks on LLMs,” HiddenLayer Innovation Hub, 2024. [Online]. Available: https://hiddenlayer.com/innovation-hub/prompt-injection-attacks-on-llms/. Accessed: Oct. 29, 2025.