🚀 LLMs Desmistificados: Da Palavra ao "Pensamento", Como a IA Generativa Realmente Funciona

- #IA Generativa

Introdução: A Era da Inteligência Artificial

Vivemos, sem dúvida, o período mais tecnologicamente avançado da história humana.

A Inteligência Artificial, que antes habitava apenas livros de ficção científica, hoje está integrada ao nosso cotidiano. Ela entrou em nossas vidas de forma tão natural que, muitas vezes, mal percebemos sua presença silenciosa.

Ferramentas como ChatGPT popularizaram o diálogo com máquinas de uma forma irreversível.

Agora, pedimos para a IA revisar textos, criar imagens do zero, auxiliar em processos terapêuticos, desenvolver códigos complexos, responder dúvidas de estudo, elaborar documentos profissionais e até sugerir decisões estratégicas.

O que antes exigia meses de dedicação humana, hoje pode ser construído em minutos.

Mas por trás dessa revolução existe um motor central, uma tecnologia fascinante: os Modelos de Linguagem de Grande Escala, conhecidos pela sigla LLMs.

Neste artigo, vamos abrir essa "caixa-preta" juntos.

Não vamos ver apenas o que um LLM faz — mas como ele funciona, de onde essa ideia veio e por que ele mudou o mundo para sempre.

Vamos caminhar desde o imaginário mitológico da Grécia Antiga, passar pelos laboratórios de ciência da computação, até chegar ao funcionamento interno do ChatGPT e modelos como o Gemini.

Respira fundo. Prepare seu café. Vamos começar essa jornada

🏛️ O Sonho Ancestral: A "IA" na Mitologia Grega

Muito antes dos computadores, dos chips de silício e da internet, já existia o desejo humano de criar inteligência artificial.

Os gregos antigos, em sua sabedoria, imaginavam autômatos: seres artificiais criados por artesãos divinos, capazes de agir sozinhos e obedecer a comandos.

O exemplo mais conhecido desse sonho é Talos, o gigante de bronze. Segundo a lenda, ele foi forjado por Hefesto, o deus da invenção, do fogo e da metalurgia. A missão de Talos era simples, mas vital: patrulhar a ilha de Creta e atacar qualquer invasor que se aproximasse.

Talos não tinha alma. Ele não pensava como humano. Mas ele executava sua função com precisão mecânica inigualável.

As Assistentes de Ouro

Outro exemplo ainda mais fascinante e próximo da nossa realidade atual está descrito na Ilíada, de Homero. Hefesto possuía assistentes femininas feitas inteiramente de ouro. Elas não eram estátuas imóveis; elas falavam, aprendiam e ajudavam o deus em sua forja.

O texto antigo as descreve com atributos surpreendentes:

- Tinham “voz” e fala articulada.

- Possuíam “força” para o trabalho.

- E, o mais impressionante: tinham "mente no peito".

Ou seja, eram descritas como seres artificiais conscientes o suficiente para aprender e colaborar com seu criador.

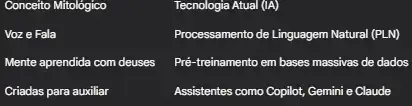

Quando olhamos para isso com nossas lentes modernas, o paralelo é assustador:

Conceito Mitológico Tecnologia Atual (IA)Voz e Fala Processamento de Linguagem Natural (PLN)Mente aprendida com deuses Pré-treinamento em bases massivas de dados Criadas para auxiliar Assistentes como Copilot, Gemini e Claude

A tecnologia é moderna. Mas o desejo de criar uma mente artificial é ancestral.

📜 Da Mitologia à Matemática: O Teste de Turing

Saltando da Grécia Antiga para o século XX, o sonho tornou-se ciência.

Não podemos falar de IA sem citar Alan Turing, o pai da computação. Em 1950, ele fez a pergunta que mudaria tudo: "As máquinas podem pensar?"

Turing propôs que, se uma máquina pudesse conversar por texto com um humano e enganá-lo, fazendo-o acreditar que falava com outra pessoa, ela poderia ser considerada inteligente.

Por décadas, isso foi apenas teoria.

Os primeiros chatbots, como a ELIZA nos anos 60, eram apenas truques de roteiro. Eles não entendiam nada; apenas repetiam palavras-chave.

Mas tudo mudou na última década. Com o surgimento do Deep Learning (Aprendizado Profundo) e o aumento brutal do poder de processamento, finalmente criamos máquinas que passariam no teste de Turing com facilidade.

Entram em cena os LLMs.

🧠 O que é um LLM?

Um LLM (Large Language Model) é um modelo de Machine Learning treinado para reconhecer e gerar linguagem humana.

Ele pode:

- Explicar conceitos

- Responder perguntas

- Escrever histórias e códigos

- Criar resumos

- Traduzir idiomas

- Gerar imagens (quando combinado com modelos de visão)

- Manter diálogos longos com coerência

Mas tudo isso se resume a uma única habilidade fundamental:

Ele prevê a próxima palavra mais provável dentro de um contexto.

Ele não pensa, não interpreta realidade, não sente.

- Mas prevê com tamanha precisão que produz a ilusão da compreensão.

📚 Como um LLM Aprende?

Um LLM aprende analisando enormes volumes de dados:

- Livros

- Artigos

- Repositórios de código

- Fóruns

- Conversas

- Sites públicos

Durante o treinamento, ele não decora frases.

Ele identifica padrões:

- Como as pessoas organizam ideias

- Como conectam conceitos

- Como usam gramática

- Como argumentam

- Como contam histórias

Assim, o modelo internaliza a estrutura da linguagem.

🧩 O Grande Ilusionista: LLM Não Pensa — Ele Prevê

Esse é um dos pontos mais cruciais e mais mal compreendidos sobre a Inteligência Artificial Generativa atual.

É fundamental que você, como estudante ou profissional de tecnologia, entenda: LLMs não possuem consciência.

Eles não têm emoções. Eles não têm crenças políticas ou religiosas. Eles não têm intenções ou desejos ocultos. Eles não "querem" te ajudar. Eles não "sentem" medo de errar.

Quando você faz uma pergunta ao ChatGPT, o que acontece nos bastidores não é um raciocínio biológico. Não há sinapses disparando.

O que ocorre é um cálculo matemático massivo e instantâneo.

O modelo está constantemente se perguntando: "Dada a sequência de palavras que vieram antes, qual é a próxima palavra (token) mais provável estatisticamente de aparecer agora?"

E ele repete esse processo. Palavra por palavra. Milissegundo por milissegundo. Até formar a frase completa que aparece na sua tela.

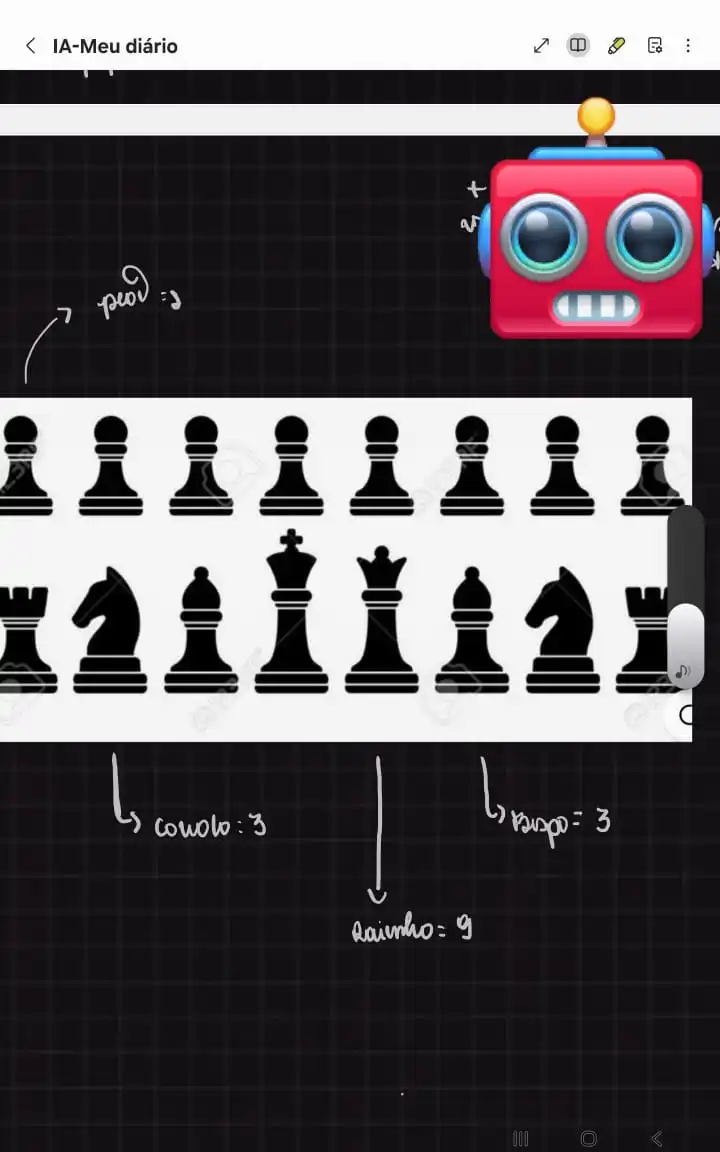

♟️ A Analogia do Xadrez: Pontos e Probabilidades

Para visualizar como essa matemática funciona sem precisar ver equações complexas, vamos usar uma analogia clássica: o jogo de xadrez.

Observe a imagem abaixo, retirada diretamente do meu caderno de estudos, onde mapeei os valores teóricos das peças:

No xadrez, cada peça tem um "peso" estratégico.

- Um Peão vale 1 ponto.

- Um Cavalo vale cerca de 3 pontos.

- Uma Torre vale 5 pontos.

- Uma Rainha (Dama) vale 9 pontos.

Um computador que joga xadrez decide o próximo movimento calculando qual jogada trará a maior vantagem numérica no tabuleiro. Ele não "gosta" de ganhar; ele apenas maximiza os pontos.

O Tabuleiro das Palavras

O LLM joga um jogo muito parecido, mas o tabuleiro dele é o vocabulário humano.

Imagine que o modelo recebeu a frase incompleta: "O céu hoje está muito..."

O modelo analisa seu banco de dados gigantesco. Ele verifica quais palavras costumam aparecer depois dessa sequência específica.

Ele atribui "pontos" (probabilidades) para as opções:

- A palavra "azul" ganha 9.000 pontos (probabilidade altíssima).

- A palavra "nublado" ganha 5.000 pontos (probabilidade média).

- A palavra "feliz" ganha 100 pontos (baixa probabilidade, mas possível poeticamente).

- A palavra "torradeira" ganha 0 pontos (probabilidade nula, sem sentido).

Assim como no xadrez você moveria a peça para ganhar vantagem, o LLM escolhe a palavra "azul" (ou "nublado") porque ela tem o maior valor estatístico naquele contexto.

Ele não sabe o que é o céu físico. Ele não sabe o que é a cor azul visualmente.

Ele apenas sabe que, matematicamente, essas duas "peças" costumam aparecer juntas no tabuleiro da linguagem. É um jogo de previsão executado com perfeição.

⚙️ Por Dentro da Máquina: Embeddings e Transformers

Para os mais curiosos tecnicamente, precisamos falar sobre duas tecnologias que tornaram isso possível: Embeddings e Transformers.

1. Embeddings (Vetores)

Computadores não entendem palavras, eles entendem números. Para o computador, a palavra "Maçã" não significa nada.

Para resolver isso, transformamos palavras em listas de números chamadas Vetores. Imagine um gráfico gigante. Nesse gráfico, a palavra "Rei" fica matematicamente próxima da palavra "Rainha". A palavra "Maçã" fica próxima de "Banana", mas longe de "Carro".

Isso permite que o computador calcule significados. Ele pode fazer contas como: Rei - Homem + Mulher = Rainha.

2. A Arquitetura Transformer

Lançada pelo Google em 2017, essa arquitetura mudou tudo. Antes, as IAs liam frases palavra por palavra, da esquerda para a direita. Se a frase fosse longa, elas esqueciam o começo.

O Transformer introduziu o mecanismo de "Atenção" (Self-Attention).

Isso permite que o modelo olhe para a frase inteira de uma vez e entenda o contexto de cada palavra em relação a todas as outras.

Se eu digo: "O banco fechou cedo", a IA sabe que é um banco financeiro. Se eu digo: "Sentei no banco da praça", a IA sabe que é um assento.

O Transformer permite essa compreensão profunda do contexto, essencial para a fluidez que vemos hoje.

🔧 O Ciclo de Vida de um LLM

Um modelo de IA não nasce sabendo. Ele passa por um ciclo de vida rigoroso de três estágios principais:

Fase 1: Pré-treinamento (A Faculdade)

Esta é a fase mais cara e demorada. Usando milhares de placas de vídeo (GPUs) potentes, o modelo é exposto a petabytes de texto.

Ele aprende gramática, fatos sobre o mundo, raciocínio lógico básico e até alguns vieses. O resultado é um "modelo base". Ele é inteligente, mas bruto. Se você pedir uma receita de bolo, ele pode continuar escrevendo uma lista de ingredientes aleatórios em vez de explicar o modo de preparo.

Fase 2: Ajuste Fino (Fine-Tuning - A Especialização)

Aqui transformamos o modelo bruto em um assistente útil. O método mais famoso é o RLHF (Aprendizado por Reforço com Feedback Humano).

Humanos conversam com a IA, avaliam suas respostas e dão notas.

- Resposta boa? A IA ganha uma recompensa digital.

- Resposta ruim ou perigosa? A IA é penalizada.

Isso ensina o modelo a ser prestativo, seguir instruções e evitar conteúdos tóxicos.

Fase 3: Inferência (O Trabalho)

É o momento em que você usa o ChatGPT. O modelo já está treinado. Ele recebe seu texto, processa os números e gera a resposta.

Um detalhe curioso: existe um parâmetro chamado Temperatura.

- Temperatura baixa (0.1): O modelo é muito focado, repetitivo e preciso.

- Temperatura alta (0.9): O modelo arrisca mais, sendo mais criativo e imprevisível.

👻 Quando a Máquina Mente: As Alucinações

Apesar de impressionantes, os LLMs têm um defeito crítico que todo usuário deve conhecer. Eles podem mentir com total confiança.

Na área técnica, chamamos isso de Alucinação.

Como vimos, o modelo é uma máquina probabilística, não um banco de dados de fatos verificados. O objetivo dele é completar a frase de forma coerente, não necessariamente verdadeira.

Se ele não souber a resposta, mas o padrão estatístico sugerir algo que parece uma resposta correta, ele vai inventar.

Por que isso acontece?

- Falta de 'Grounding': O modelo não tem acesso ao mundo real em tempo real (na maioria dos casos base), apenas aos textos que leu no passado.

- Pressão por Resposta: Ele foi treinado para agradar e responder sempre, o que o incentiva a "chutar" em vez de ficar calado.

Existem casos famosos de advogados que usaram o ChatGPT para escrever petições e a IA inventou leis e precedentes que nunca existiram.

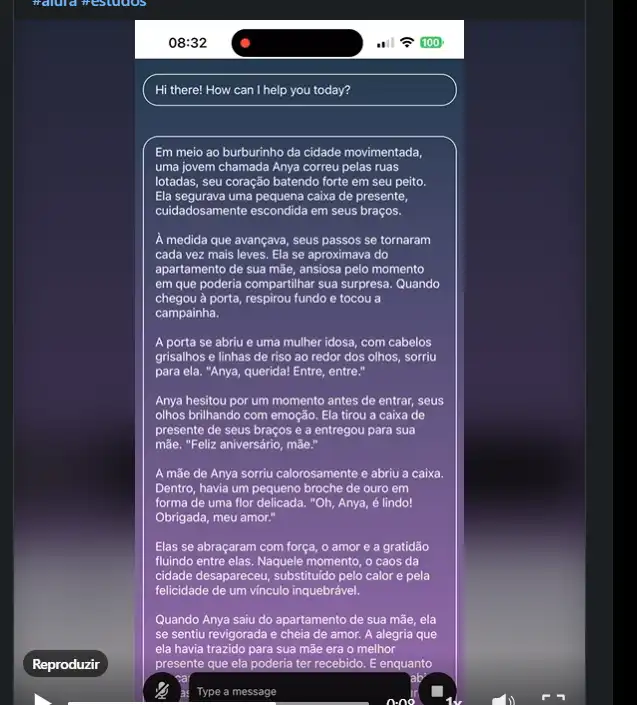

🧪 Caso Prático: Construindo um Chatbot com Gemini + React Native

Falar sobre a teoria é fascinante, mas a melhor forma de aprender é colocando a mão na massa.

Durante a Imersão IA da Alura + Google, decidi transformar o aprendizado teórico em um produto real: um aplicativo de chat capaz de conversar naturalmente.

Objetivo do Projeto: Criar um chatbot funcional para Android/iOS usando React Native no front-end e a poderosa API do Gemini (do Google) como o cérebro da operação.

🔧 Arquitetura do Projeto

Para que o app funcione, precisamos de três peças se comunicando:

- O App (Front-end): A tela onde o usuário digita.

- O Servidor (Back-end): Um código em Python que recebe a mensagem e segura a chave de segurança.

- A Inteligência (API do Gemini): O modelo do Google que gera a resposta.

O fluxo é: Usuário digita → App envia para Python → Python pergunta pro Gemini → Gemini responde → App mostra na tela.

🐍 O Código no Python (O Cérebro)

No backend, usamos a biblioteca oficial do Google. Veja como é simples conectar com uma das IAs mais poderosas do mundo:

Python

import google.generativeai as genai

# Configurando a chave de acesso (como uma senha)

genai.configure(api_key="SUA_API_KEY_AQUI")

def responder_usuario(mensagem):

# Escolhendo o modelo "Gemini Pro" (focado em texto)

model = genai.GenerativeModel("gemini-pro")

# Enviando a pergunta e esperando a mágica

resposta = model.generate_content(mensagem)

# Retornando apenas o texto da resposta

return resposta.text

O que esse código faz?

- Importa a ferramenta do Google.

- Autentica sua conta.

- Seleciona o modelo "Pro" (existem modelos para visão e vídeo também).

- Gera o conteúdo baseado no que o usuário mandou.

📱 O Código no React Native (A Cara)

No aplicativo celular, precisamos enviar essa mensagem para o nosso Python. Usamos uma função assíncrona (async) porque a resposta da IA não é instantânea, leva alguns segundos.

JavaScript

const enviarMensagem = async () => {

// Enviamos a mensagem para o nosso servidor

const resposta = await fetch("URL_DO_SEU_PYTHON", {

method: "POST",

headers: { "Content-Type": "application/json" },

body: JSON.stringify({ mensagem: "Olá, IA!" }),

});

// Transformamos a resposta em texto legível

const data = await resposta.json();

// Atualizamos a lista de mensagens na tela do celular

setMensagens([...mensagens, { autor: "IA", texto: data.resposta }]);

};

Esse exemplo mostra como a barreira de entrada diminuiu. Com menos de 20 linhas de código, conectamos um aplicativo móvel a um supercomputador do Google.

Zero complicação. Entrega máxima de valor.

🎯 O que esse projeto me ensinou

Criar um chatbot não é apenas sobre escrever linhas de código. É sobre entender a Engenharia de Prompt.

Percebi durante os testes que a qualidade da resposta da IA depende 80% da qualidade da sua pergunta (Prompt).

Se você apenas disser "Responda isso", a IA será genérica. Se você disser "Você é um especialista em História da Arte. Responda a isso de forma didática para uma criança de 10 anos", a resposta será brilhante.

A IA responde melhor quando você orienta o contexto. Quem aprende a conversar com a IA (Prompting), aprende a construir soluções melhores com ela.

IAs não substituem pessoas. Elas amplificam as pessoas que sabem usá-las.

💼 O Fim dos Programadores? O Impacto no Mercado

A pergunta de um milhão de dólares que todos fazem: "A IA vai roubar o meu emprego?"

A resposta curta é: Não. A resposta longa e honesta é: Ela vai mudar radicalmente como você trabalha.

Ferramentas como GitHub Copilot e o próprio Gemini Code Assist já provam isso diariamente. Estudos mostram que desenvolvedores usando assistentes de IA codificam até 50% mais rápido.

A IA é excelente em tarefas repetitivas e chatas:

- Criar testes unitários (que ninguém gosta de fazer).

- Escrever códigos padrão (boilerplate).

- Documentar funções complexas.

- Encontrar bugs simples de sintaxe.

No entanto, a IA ainda falha (e muito) em:

- Arquitetura de software complexa.

- Entender regras de negócio subjetivas de um cliente.

- Criatividade para resolver problemas inéditos.

O mercado está migrando. Estamos deixando de ser 'digitadores de código' para nos tornarmos 'arquitetos de soluções baseadas em IA'.

O desenvolvedor do futuro não é aquele que decora a sintaxe de Java ou Python. É aquele que sabe identificar um problema e usar a IA para construir a solução mais eficiente.

⚖️ O Lado Sombrio: Ética e Viés nos Dados

Nem tudo são flores no mundo da IA Generativa. Precisamos falar sobre ética.

Como explicamos, o modelo aprende lendo a internet. E a internet é um lugar cheio de preconceitos, racismo, sexismo e desinformação.

Se um modelo for treinado predominantemente com livros de uma única cultura, ele terá uma visão de mundo enviesada. Isso é o que chamamos de Viés Algorítmico.

Se você pedir para uma IA gerar uma imagem de "um médico", ela tende a gerar um homem branco. Se pedir "uma enfermeira", gera uma mulher. Isso reflete os estereótipos dos dados de treinamento, não a realidade ideal.

As grandes empresas usam técnicas avançadas de filtragem para tentar limpar esses comportamentos tóxicos, mas o desafio persiste.

Como desenvolvedores e criadores de tecnologia, temos a responsabilidade ética de monitorar as saídas desses sistemas e não aceitar tudo o que a máquina diz como verdade absoluta.

🎓 Próximos Passos: Aprofundando no Santander 2025

Esse projeto do chatbot foi apenas o começo da minha jornada.

A área de dados é vasta e a IA é apenas a ponta do iceberg. Para dominar essa tecnologia, é preciso entender a base: Python, Estatística e Manipulação de Dados.

Estou prestes a dar o próximo passo na minha trajetória acadêmica e profissional: participar do Bootcamp Santander 2025 - Ciência de Dados com Python, aqui na DIO.

Essa trilha reúne exatamente aquilo que mais me atrai na área: a união entre a lógica da programação e a magia da análise de dados.

Meu objetivo é ir além de apenas usar APIs prontas. Quero entender como treinar meus próprios modelos, como limpar datasets reais e como aplicar Ciência de Dados para resolver problemas de negócios no Brasil.

🏁 Conclusão: O Futuro Já Começou

Ao longo deste artigo, fizemos uma viagem longa. Saímos das forjas de Hefesto na Grécia Antiga, passamos pelas teorias de Alan Turing e chegamos aos modernos data centers que rodam o Gemini e o GPT.

Vimos que os LLMs não são seres conscientes. Eles não são máquinas “pensantes” no sentido humano da palavra.

Eles são grandes modelos matemáticos, estatísticos e probabilísticos. Eles são espelhos de todo o conhecimento (e desconhecimento) que a humanidade produziu e colocou na internet.

Eles não entendem o mundo — mas conseguem modelar seus padrões com perfeição. E isso, por si só, é uma ferramenta poderosa.

Estamos vivendo uma transformação social semelhante ao surgimento da eletricidade ou da internet.

Para nós, profissionais de tecnologia e design, o segredo não é competir com a máquina. É colaborar com ela. A IA Generativa não vai “tomar o seu lugar”; mas um profissional que sabe usar IA vai tomar o lugar de quem não sabe.

E o próximo passo? Você já deu o primeiro: entender o motor por trás da tecnologia lendo este artigo.

O próximo é experimentar. Abra o editor de código. Teste prompts diferentes. Tente "quebrar" o modelo. Analise os padrões.

O futuro não está chegando. Ele já começou. E está esperando pelo seu primeiro comando.

💬 Quero ouvir você!

A Inteligência Artificial já mudou alguma coisa na sua rotina de estudos ou trabalho? Você sente que ela ajuda ou atrapalha sua criatividade?

Deixe seu comentário abaixo, vamos debater sobre o futuro da nossa profissão!

Referências Bibliográficas

- Microsoft Learn: Fundamentals of Generative AI and LLMs.

- Vaswani, A. et al. (2017): Attention Is All You Need (O paper que criou os Transformers).

- OpenAI Research: Documentation on GPT-4 and Embeddings.

- Google DeepMind: Gemini Technical Report.

- Alura Artigos: Tipos de LLMs e suas aplicações.

- IBM Tech: History of Artificial Intelligence.