LLMs, LangChain, RAG + Projeto Prático

"Inteligência Artificial não é o futuro, ela é o presente. E, quem não se adapta, acabará ficando pra trás."

Se você não é do ramo de tecnologia, não é sua obrigação saber como desenvolver uma ferramenta ultra poderosa, mas é importante que você saiba como alguns conceitos e como usar ferramentas que foram criadas para somar, para ajudar a facilitar nosso dia-a-dia, seja na vida profissional ou na pessoal.

Você sabe o que é LLM? Os modelos de linguagem grande (LLM = Large Language Models) são modelos que foram treinados com enormes quantidades de conteúdo, para que possam compreender a linguagem humana e realizar as atividades que solicitamos. Hoje em dia, há centenas, e provavelmente milhares de ferramentas que são modelos de LLM, e você já conhece algum deles: ChatGPT, Gemini, Mistral, Groq, etc.

Quando é dito que eles são treinados para compreender a linguagem humana, funciona exatamente assim:

- Se você escrever com uma linguagem não tão formal, e pedir que ele responda no mesmo tom, o modelo vai compreender;

- Se você pedir para que ele explique algo como se estivesse explicando para uma criança de 5 anos, ele também vai compreender;

Claro que, a forma como você pede, e a ordem em que você pede, pode influenciar no tamanho e na qualidade da resposta que o modelo vai te entregar. O nome dessa técnica é Engenharia de Prompts, e falaremos dele em outro artigo aqui na plataforma.

LangChain

Agora que sabemos um pouco mais sobre como funciona as LLMs, podemos conversar um pouco sobre LangChain. LangChain é um framework que auxilia desenvolvedores a construírem aplicações que utilizam modelos LLM. Contextualizando, é possível importar modelos de LLM (como a OpenAI do ChatGPT e o Groq) para dentro de sua aplicação. Ao importar o LangChain, você permite que sua aplicação registre dados em memória e que ela consulte bancos de dados para responder perguntas de forma mais assertiva, deixando seu código mais "parrudo" e completo.

RAG

RAG (Retrieval-Augmented Generation, ou Geração Aumentada por Recuperação) transforma ainda mais nossa aplicação. Imagine o RAG como uma grande biblioteca sobre um tema. Jurídico, por exemplo. É possível alimentar a sua aplicação com vários PDF's sobre determinadas leis e casos onde elas foram aplicadas. É possível que seu programa consulte os arquivos que você fez upload e te entregue uma resposta baseada em tudo o que ele leu.

Isso é possível graças aos embeddings. Embeddings são representações numéricas das palavras. Cada palavra é transformada em um vetor de números. Vamos considerar o exemplo abaixo:

Gato = [0.38, 0,42, 0,54]

Felino = [0.35, 0.45, 0,63]

Se houver algo sobre gatos nos documentos, e você pesquisar sobre felinos, a aplicação trará uma resposta próxima ao que você busca. Porém, se os documentos forem sobre felinos e você pesquisar sobre árvores, a resposta já não será tão assertiva.

Imaginou como isso pode ser útil num sistema RAG no ramo jurídico? E no ramo hospitalar? É por isso que profissionais com conhecimento em desenvolvimento de RAGs são tão requisitados e muito bem pagos hoje em dia.

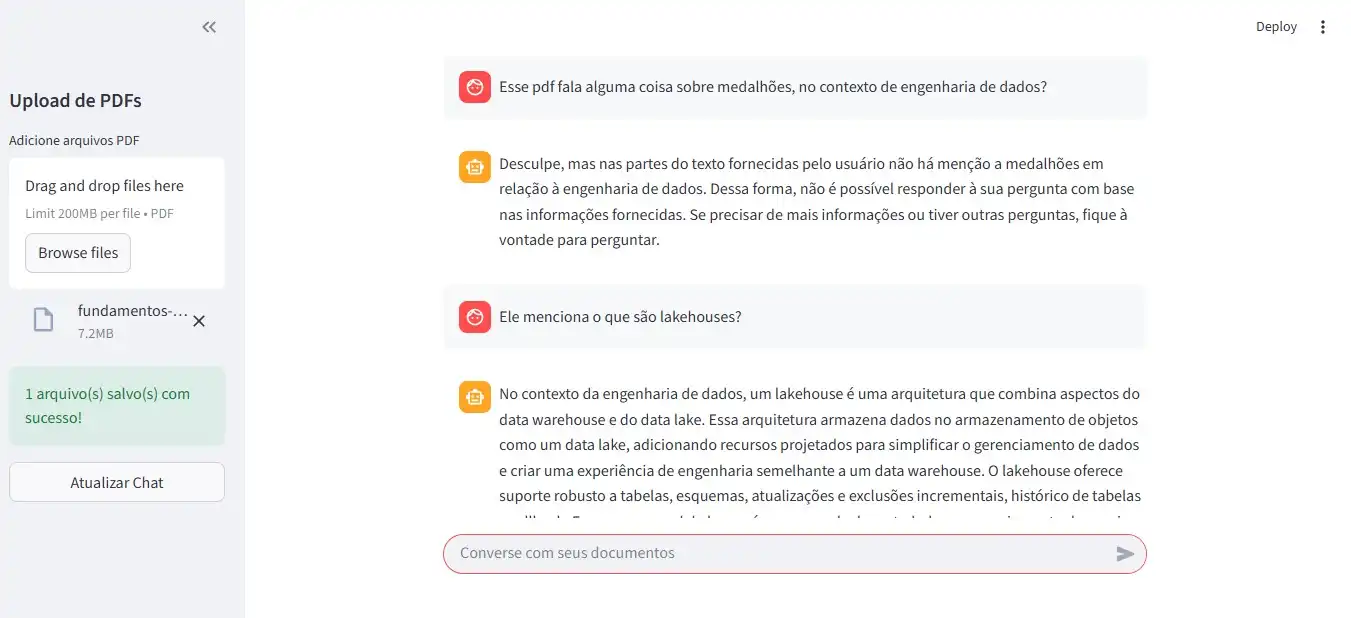

Além de um uma explicação escrita, também gostaria de mostrar a você que está lendo esse artigo um projeto prático no qual eu trabalhei que envolve tudo o que foi mencionado aqui: modelos de LLM, LangChain e RAG. É possível realizar upload de arquivos PDF (mais de um ao mesmo tempo) e realizar perguntas para o modelo LLM. Para esse exemplo, fiz upload de um arquivo sobre fundamentos de engenharia de dados. Para o desenvolvimento da aplicação, utilizei Python, o modelo LLM da OpenAI e Streamlit para a parte visual.

Sempre que você realizar um novo upload, os antigos são deletados da memória, para que não haja divergências de assunto e o modelo entregue respostas com alucinações.

O objetivo desse artigo foi falar sobre os conceitos de LLMs, LangChain e RAG, e como a utilização deles pode entregar um resultado poderoso para os desenvolvedores e para usuários comuns. Espero que, de alguma forma, esse artigo agregue ao seu conhecimento.

Obs: As imagens abaixo demonstram o funcionamento da aplicação que desenvolvi