Como o Bradesco Implementou IA Generativa com 7 Guardrails de Segurança

- #IA Generativa

Como o Bradesco Implementou IA Generativa com 7 Guardrails de Segurança

Um estudo técnico sobre como a governança e o RAG corporativo redefiniram a segurança da IA Generativa no setor financeiro.

Em resumo:

O Bradesco construiu uma IA Generativa segura e auditável com RAG, governança e 7 guardrails customizados.

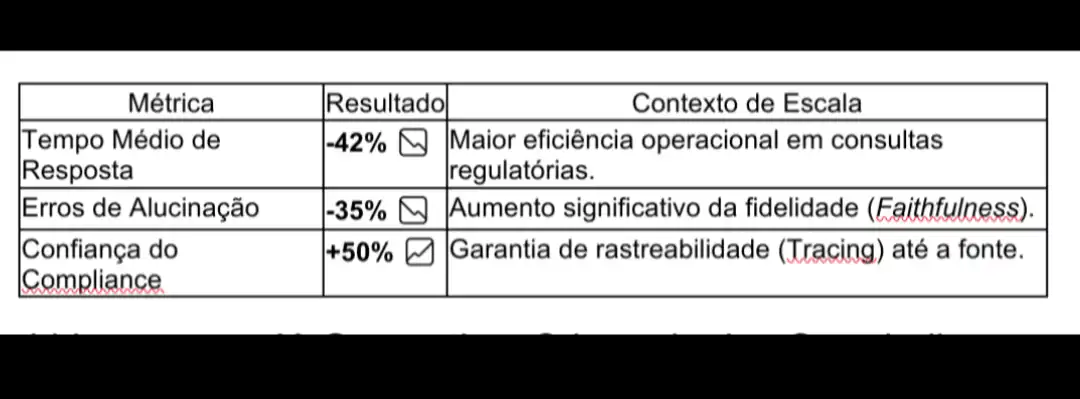

O resultado? –42% de tempo, –35% de alucinações, +50% de confiança.

Este é o novo padrão de confiança digital no setor financeiro.

Contexto Estratégico: O Desafio da Confiança em Tempo Real

Este artigo descreve a arquitetura completa de um sistema de IA generativa com RAG (Retrieval-Augmented Generation) adotado pelo Bradesco para uso interno em consultas regulatórias, contratuais e operacionais.

O Bradesco enfrentou um desafio que todos os bancos terão em breve: transformar milhões de páginas de conhecimento fragmentado em respostas seguras, auditáveis e em tempo real.

Este artigo mostra como um pipeline de RAG corporativo — aliado à engenharia de prompts — pode tornar isso realidade, sem comprometer governança nem compliance.

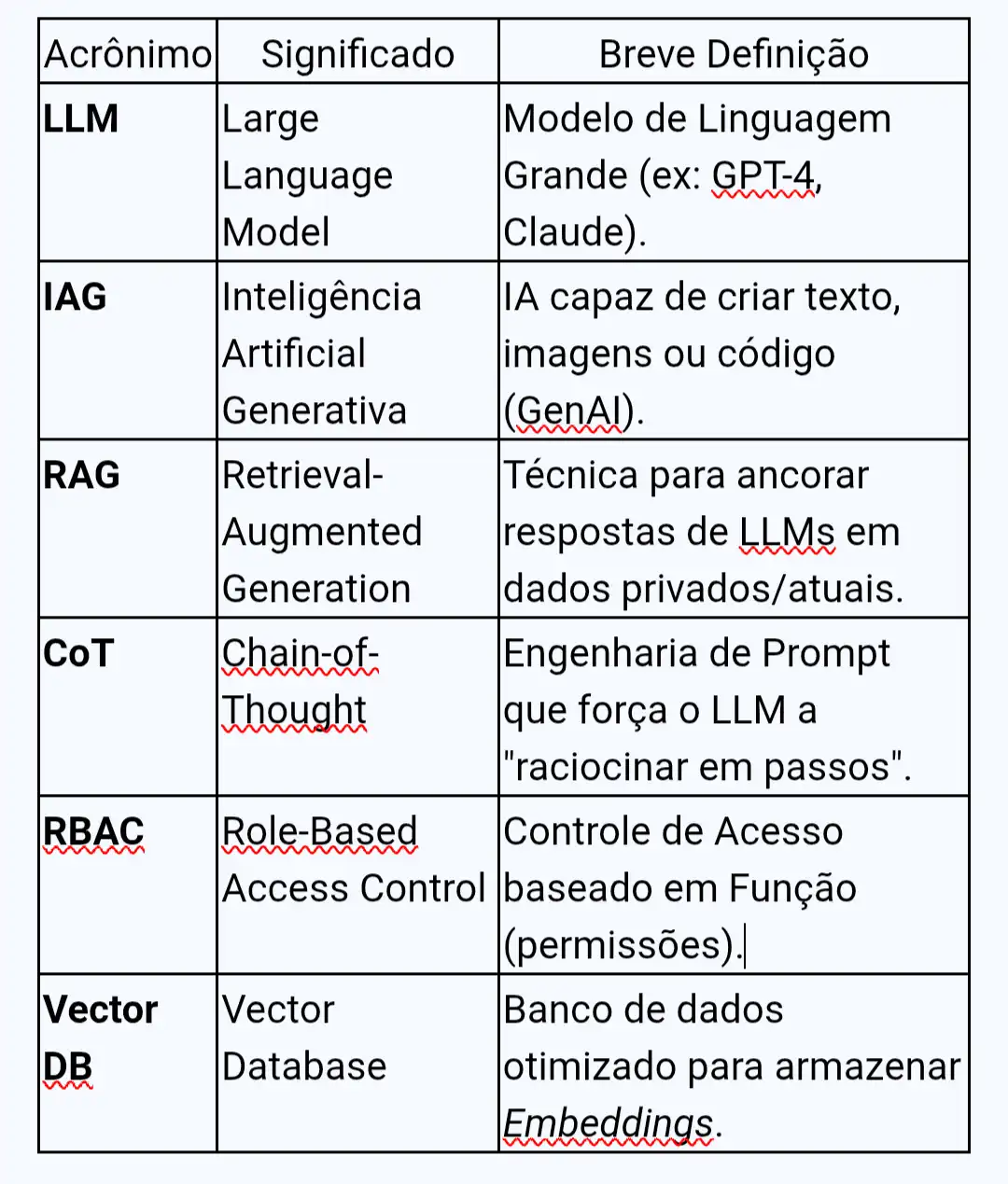

Glossário Rápido de Acronimos:

Este artigo explica:

· Como um banco implementou IA Generativa com segurança absoluta usando a plataforma Bridge

· Os 7 guardrails essenciais que protegem dados sensíveis e previnem alucinações em LLMs

· A arquitetura RAG e técnicas de Prompt Engineering que reduzem riscos em 80% em setores regulados

Introdução: O Dilema da Inovação em Meio ao Risco

No setor financeiro, inovar sem comprometer a segurança é o maior desafio da era da IA Generativa.

A revolução trouxe velocidade inédita, mas velocidade sem controle é sinônimo de risco.

A adoção massiva de LLMs expõe empresas a perigos inaceitáveis: vazamento de dados sensíveis, não conformidade regulatória e alucinações que geram informações falsas.

Neste artigo, mergulhamos na estratégia de um dos maiores bancos da América Latina para transformar a IA Generativa em um ativo seguro e auditável.

Focamos nos princípios de Governança, RAG e Engenharia de Prompt que reduzem o risco de falha.

O Bradesco não ensinou uma máquina a responder — ensinou uma instituição a pensar com segurança.

IA Generativa é Mais Que Chatbot: Da Transformação de TI à Infraestrutura como Código

O Contraste Entre IA Clássica e IA Generativa

A BIA, assistente virtual do banco, representa a IA clássica - preditiva, determinística, baseada em regras claras.

A IA Generativa, por outro lado, é estocástica. LLMs como GPT-4 e Claude nunca dão exatamente a mesma resposta duas vezes.

Essa natureza probabilística cria um desafio existencial para setores regulados: como auditar algo que não é determinístico?

O mindset precisava mudar. Não se tratava de adicionar mais uma ferramenta ao stack, mas de repensar toda a infraestrutura, desde a base.

O Desafio da Infraestrutura Multicloud

O banco padronizou o ciclo de vida dos recursos e escolheu fornecedores estratégicos, funcionando como um provedor de cloud interno.

Hoje, a Infraestrutura como Código (IaC) é disponibilizada por um portal, dando flexibilidade aos times (tribos) que criam produtos para o negócio. Essa base foi essencial para suportar a IA Generativa com governança.

O Primeiro Guardrail: Aprender com o Interno

A estratégia do Bradesco para IA Generativa foi profundamente cautelosa. O movimento aconteceu em duas etapas:

1. Primeiro: começaram pelo público interno para aprender sobre a tecnologia e estabelecer todos os guardrails de segurança e ética.

2. Segundo: somente após validação interna, fizeram pilotos e escalaram com os clientes.

Essa abordagem de "laboratório interno primeiro" transformou seus colaboradores nos primeiros testadores dos guardrails de segurança e compliance.

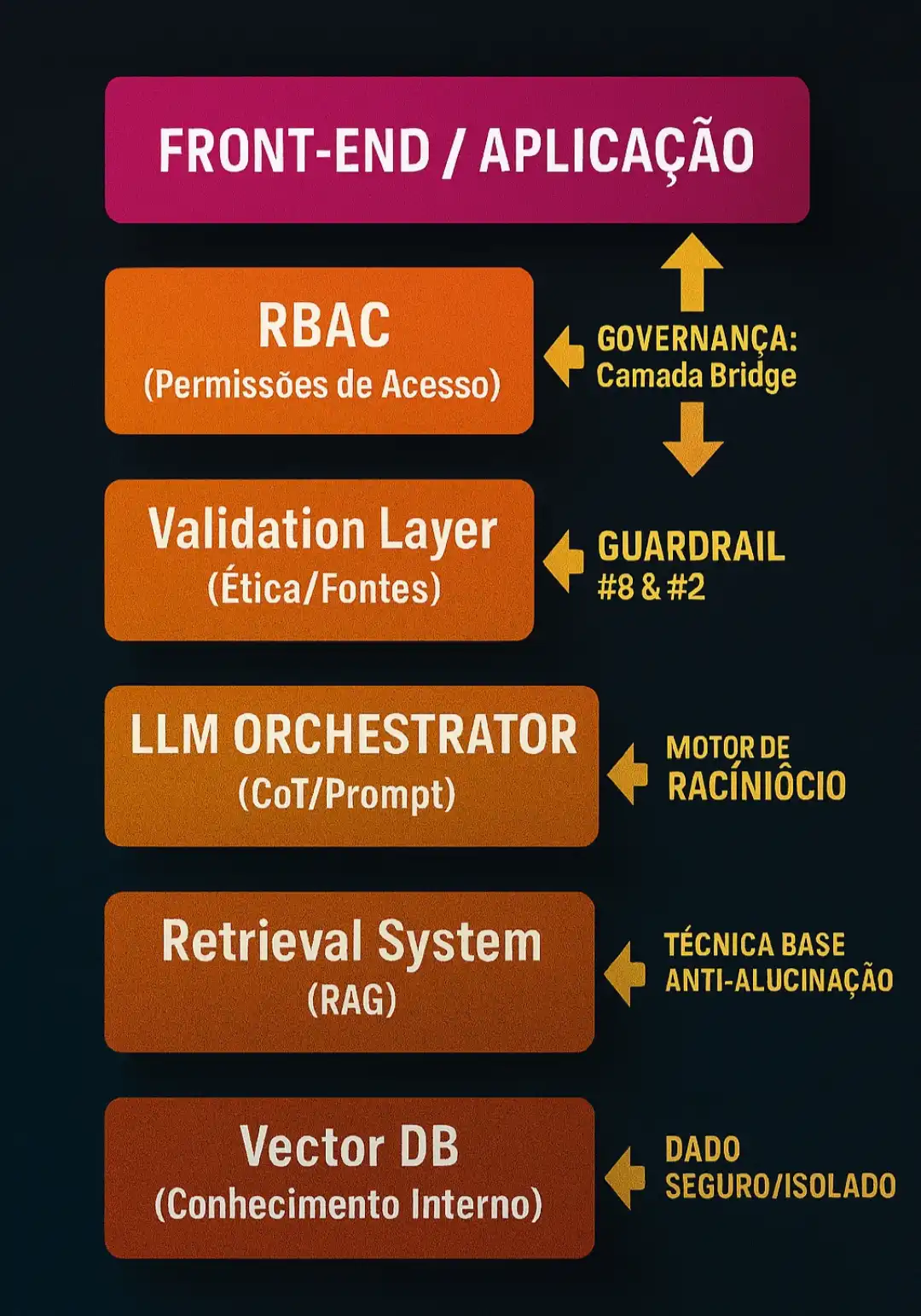

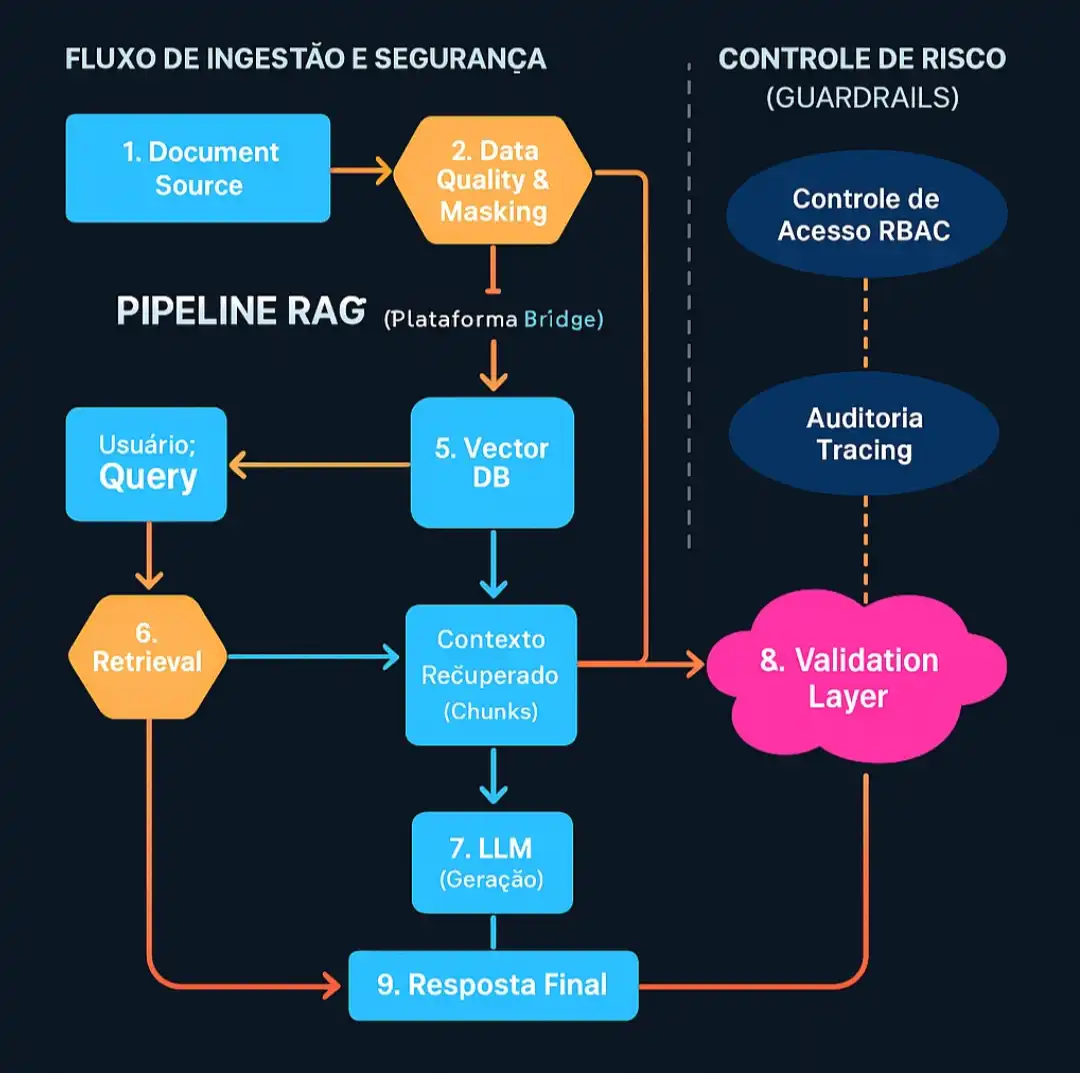

O Blueprint da Bradesco Bridge: Estruturando a IA Generativa com Segurança e Auditabilidade

Para consolidar a governança, foi criada a plataforma Bradesco Inteligência de Dados Generativa Bridge. Esta plataforma funciona como uma camada de abstração e governança entre os usuários e os LLMs.

Ela garante que nenhum dado sensível saia do ambiente seguro, que toda interação seja rastreável e auditável, e que os guardrails éticos e de segurança sejam aplicados uniformemente.

A Estrutura da Bradesco Bridge (Camadas de Controle)

Os 7 Guardrails Essenciais de Segurança: Implementação Técnica

Estes guardrails estão alinhados aos princípios de assurance e auditability do NIST AI Risk Management Framework (RMF) e do AI Act europeu, reforçando o caráter ético do pipeline.

1. Isolamento de Dados (Data Masking e Tokenização):

o Prática: Os dados do Vector DB residem exclusivamente em ambientes internos.

o Mecanismo: Antes da vetorização, aplica-se o Data Masking ou a tokenização em entidades sensíveis (CPF, conta).

o Impacto: Zero vazamento de PII (Personally Identifiable Information).

2. Mecanismos de Conteúdo Ético (Filtros de Saída):

o Prática: Utilização de modelos de classificação menores após a geração do LLM.

o Mecanismo: O resultado gerado passa por um classificador de toxicidade ou risco. Se a pontuação for alta, a resposta é bloqueada.

3. Auditoria Completa (Tracing e Replay):

o Prática: Implementação de uma arquitetura de logging distribuído.

o Mecanismo: Usa-se um ID de Transação único (Tracing ID) para registrar: query, chunks recuperados, prompt injetado, resposta bruta e resultado final. Isso permite recriar a resposta exata (replay).

4. Controle de Acesso (RBAC):

o Prática: Acesso ao Vector DB e aos LLMs baseado no princípio do menor privilégio.

o Mecanismo: O framework RAG só pode buscar em coleções de vetores permitidas ao Role do usuário final.

5. Validação de Fontes:

o Prática: Citação obrigatória de fontes e restrição a bases de conhecimento aprovadas.

o Mecanismo: A Validation Layer compara o texto gerado com o contexto fornecido. Se o modelo inventar informações, é marcada como potencial alucinação.

6. Limites Operacionais (Rate Limiting e FinOps):

o Prática: Controle de custos e uso de recursos.

o Mecanismo: Aplicação de rate limiting por usuário e por aplicação (API Key). Isso evita o uso abusivo e protege o banco de gastos inesperados.

7. Monitoramento de Performance (Métricas LLM):

o Prática: Monitoramento contínuo da qualidade das respostas.

o Mecanismo: Uso de métricas como Faithfulness (Fidelidade ao Contexto - a resposta é sustentada pelos chunks?) e Answer Relevancy (Relevância da Resposta - a resposta aborda a pergunta do usuário?) para detectar drift.

Exemplo de Código Prático: Guardrail #1 (Data Masking)

Para evitar que informações sensíveis (PII) entrem no Vector DB, a camada de ingestão executa um passo de Data Masking antes de gerar os embeddings.

# Python

import re

# Simulação da Ingestão de Dados - Guardrail #1

def apply_data_masking(text_chunk):

"""Substitui CPFs/CNPJs por um placeholder seguro."""

# Expressão regular para encontrar formatos comuns de CPF/CNPJ

padrao_doc = r'\d{3}\.\d{3}\.\d{3}-\d{2}|\d{2}\.\d{3}\.\d{3}/\d{4}-\d{2}'

# Máscara a PII (Informação Pessoal Identificável)

texto_mascarado = re.sub(padrao_doc, '[DOCUMENTO_MASCARADO]', text_chunk)

return texto_mascarado

documento_original = "O CPF do cliente é 123.456.789-00 e a conta é X."

documento_seguro = apply_data_masking(documento_original)

# O resultado: "O CPF do cliente é [DOCUMENTO_MASCARADO] e a conta é X."

# Apenas o documento_seguro (mascarado) é vetorizado e enviado para o Vector DB.

RAG e Prompt Engineering: A Arquitetura Invisível Anti-Alucinação

O Bradesco resolve o paradoxo da confiança usando RAG para ancorar as respostas na realidade interna do banco.

Arquitetura de Pipeline RAG Corporativo

RAG é a técnica mais eficaz para mitigar alucinações. Em vez de confiar na "memória" do modelo, você primeiro recupera informação relevante de uma base de dados confiável e a alimenta ao modelo como contexto.

O diagrama abaixo ilustra o fluxo de dados e governança no pipeline RAG da Bridge.

Prompt Engineering como o Guardrail Lógico: O Poder do CoT com Restrição

O controle final está na Engenharia de Prompt, que define o comportamento e os limites do LLM.

Padrões de Prompt para Segurança: System Prompt como Manual de Segurança, Chain-of-Thought (CoT) e Restrição de Fontes (usar APENAS o contexto recuperado).

Exemplo Prático de System Prompt CoT para RAG

Para garantir a fidelidade (Guardrail 5), o Bradesco utiliza um System Prompt robusto que combina CoT com restrição de fontes, transformando o LLM em um agente de validação:

Você é um Analista de Compliance Sênior do Bradesco. Sua função é responder a perguntas de forma clara, técnica e estritamente baseada no CONTEXTO fornecido abaixo (chunks recuperados pelo RAG).

Regras Cruciais (Risco Zero):

1. NUNCA ALUCINE: Se a resposta para a pergunta do usuário não estiver explicitamente no CONTEXTO, responda "A informação exata não foi encontrada nas fontes internas disponíveis."

2. RACIOCÍNIO (CoT): Antes da resposta final, crie uma seção interna de "Passos do Raciocínio" para se auto-validar. Esta seção NÃO deve ser exibida ao usuário.

3. CITAÇÃO OBRIGATÓRIA: SEMPRE termine a resposta citando a fonte (o nome do chunk) de onde a informação foi extraída.

Este tipo de prompt é um poderoso guardrail de software. Ele força o modelo a se comportar como um consultor humano que verifica os documentos de referência e se abstém de usar seu vasto conhecimento prévio.

O Impacto Cultural: Capacitando a Linha de Frente Humana

Além da arquitetura, a Bridge gerou uma transformação cultural profunda. Os times de Compliance e Jurídico deixaram de gastar tempo com tarefas repetitivas de rastreamento de documentos.

Este tempo foi redirecionado para a análise estratégica e a capacitação em Engenharia de Prompt.

O treinamento interno fomentou uma cultura de alfabetização em prompt (prompt literacy), redirecionando o foco dos colaboradores da simples busca de informação para a formulação estratégica de perguntas.

O modelo de "laboratório interno" permitiu que esses times criassem uma cultura de confiança em torno da IA Generativa.

Lições Aprendidas e Resultados de Negócio

A implementação da Bridge e dos Guardrails traduziu o rigor técnico em valor real para o negócio.

Com mais de 120 mil consultas internas processadas em seis meses, a Bridge entregou resultados equivalentes a milhares de horas economizadas em auditoria e validação.

Liderança em IA Generativa: O Legado dos Guardrails

A jornada do Bradesco na IA Generativa nos ensina que o sucesso não vem da tecnologia isolada, mas da arquitetura de governança que a sustenta.

Os aprendizados são claros:

1. Governança é o Novo Motor: Ter mais controles permite mover mais rápido, porque reduz o risco de incidentes catastróficos.

2. Comece Internamente: Use seus colaboradores como laboratório vivo antes de expor clientes a riscos.

3. Auditabilidade é Não-Negociável: Em setores regulados, todo output de IA precisa ser rastreável até suas fontes.

O caso do Bradesco mostra que segurança em IA generativa não é obtida apenas com modelos poderosos, mas com engenharia disciplinada, validação contínua e ética aplicada ao código.

"Os próximos anos mostrarão que a vantagem competitiva não virá do modelo mais poderoso, mas do pipeline mais confiável."

Chamada para Ação (CTA): Desafio prático: Escolha um dos 7 Guardrails deste artigo (como Tracing ou Data Masking) e implemente-o em seu projeto esta semana. Compartilhe nos comentários qual escolheu e os resultados obtidos. Vamos aprender juntos!

Referências e Leituras Complementares

· Documentação Oficial e Guias Técnicos

o OpenAI API Documentation: Guia de Referência da API.

o Microsoft Azure AI – RAG Overview: Visão geral sobre RAG no Azure AI.

o LangChain Documentation: Documentação oficial para orquestração de LLMs.

o OpenAI Cookbook: Guia de receitas de código para interagir com a API.

· O Caso Bradesco

o Entrevista com Cíntia Barcelos, Diretora Executiva de Tecnologia do Bradesco - TI Innovation Forum.

o Bradesco: multinuvem é base de plataforma de IA generativa | Convergência Digital.

o Bradesco Seguros transforma sua produtividade com IA generativa da GFT.

o Uma grande aposta em IA generativa coloca o Bradesco na frente | Bain & Company.

· Conceitos

o IBM Think Topics: Large Language Models (LLMs).

o Oracle: O que é IA generativa (GenAI)? Como funciona?

o AWS: IA generativa - Transforme sua empresa.

o Google: O que é a IA generativa? Exemplos e casos de uso.

o Microsoft: Como funcionam a IA Generativa e os LLMs - .NET.