Engenharia de Prompt e RAG: Como Domar os LLMs e Reduzir Alucinações na IA Generativa

- #IA Generativa

Introdução — Escrever para Transformar

Vivemos um momento em que a inteligência artificial deixou de ser apenas uma promessa tecnológica para se tornar um instrumento de transformação real. Entre as inúmeras inovações que emergem desse cenário, os Modelos de Linguagem de Grande Escala (LLMs), a Engenharia de Prompt e o RAG (Retrieval-Augmented Generation) se destacam como pilares da chamada IA Generativa — uma das áreas mais promissoras e desafiadoras da atualidade.

Neste artigo, vamos compreender como essas três abordagens se conectam para tornar os sistemas de IA mais precisos, eficientes e úteis. Exploraremos princípios técnicos, aplicações práticas e estratégias para reduzir um dos maiores problemas da IA moderna: as alucinações. O objetivo é demonstrar, com base em fundamentos sólidos, como dominar a interação entre humanos e modelos generativos pode moldar o futuro da tecnologia.

1. O que é um LLM e como ele funciona

Os Large Language Models (LLMs) são redes neurais profundas treinadas em grandes volumes de dados textuais para compreender, raciocinar e gerar linguagem natural. Esses modelos são o núcleo da IA Generativa, pois permitem que máquinas processem o idioma humano com uma naturalidade sem precedentes.

Tecnicamente, um LLM é baseado em arquiteturas de transformadores, introduzidas em 2017 com o artigo Attention is All You Need. Essa arquitetura permitiu o aprendizado contextual de palavras, ou seja, a compreensão de como cada termo se relaciona com os demais em uma sequência.

Durante o treinamento, o modelo aprende padrões linguísticos e semânticos, tornando-se capaz de prever a próxima palavra de uma frase. Esse processo, aparentemente simples, é a base da geração de texto coerente e contextual.

Principais características de um LLM:

- Treinamento com bilhões (ou trilhões) de parâmetros.

- Capacidade de generalizar conhecimento a partir de dados não estruturados.

- Habilidade de responder, traduzir, resumir e até programar.

- Modelos notáveis: GPT-4, Llama 3, Claude 3, Gemini, entre outros.

A eficácia dos LLMs depende não apenas da quantidade de dados, mas da qualidade do comando humano — o que nos leva ao conceito de Engenharia de Prompt.

2. Engenharia de Prompt — O código invisível da IA Generativa

A Engenharia de Prompt é a técnica que define como nos comunicamos com modelos de linguagem. Ela consiste em formular instruções claras e estratégicas que orientam o comportamento da IA para produzir respostas úteis, consistentes e contextualizadas.

Em termos práticos, um prompt é mais do que uma simples pergunta; é uma interface de controle sem código, que direciona o raciocínio do modelo. Um prompt bem elaborado pode transformar uma resposta genérica em uma explicação técnica precisa, ou uma ideia vaga em uma solução estruturada.

Principais tipos de prompt:

- Zero-shot prompting: o modelo responde sem exemplos prévios.

- Few-shot prompting: inclui exemplos que guiam a estrutura da resposta.

- Chain-of-Thought (CoT): estimula o raciocínio passo a passo.

- Role prompting: define o papel da IA (“Você é um engenheiro de dados...”).

Uma das habilidades mais valiosas de quem trabalha com IA Generativa é saber como iterar um prompt, testando e refinando a formulação até atingir o resultado desejado. Esse processo é análogo à depuração em programação: cada tentativa fornece novos insights sobre o comportamento do modelo.

3. RAG — Recuperação de Conhecimento e Geração Contextual

Embora os LLMs dominem a linguagem, eles enfrentam uma limitação estrutural: a dependência do conhecimento armazenado até o momento do treinamento. Para superar essa barreira, surgiu a abordagem Retrieval-Augmented Generation (RAG).

O RAG combina busca semântica e geração de texto, permitindo que o modelo acesse informações externas em tempo real. Em vez de confiar apenas na memória interna, ele recupera documentos relevantes e os utiliza como base factual para compor sua resposta.

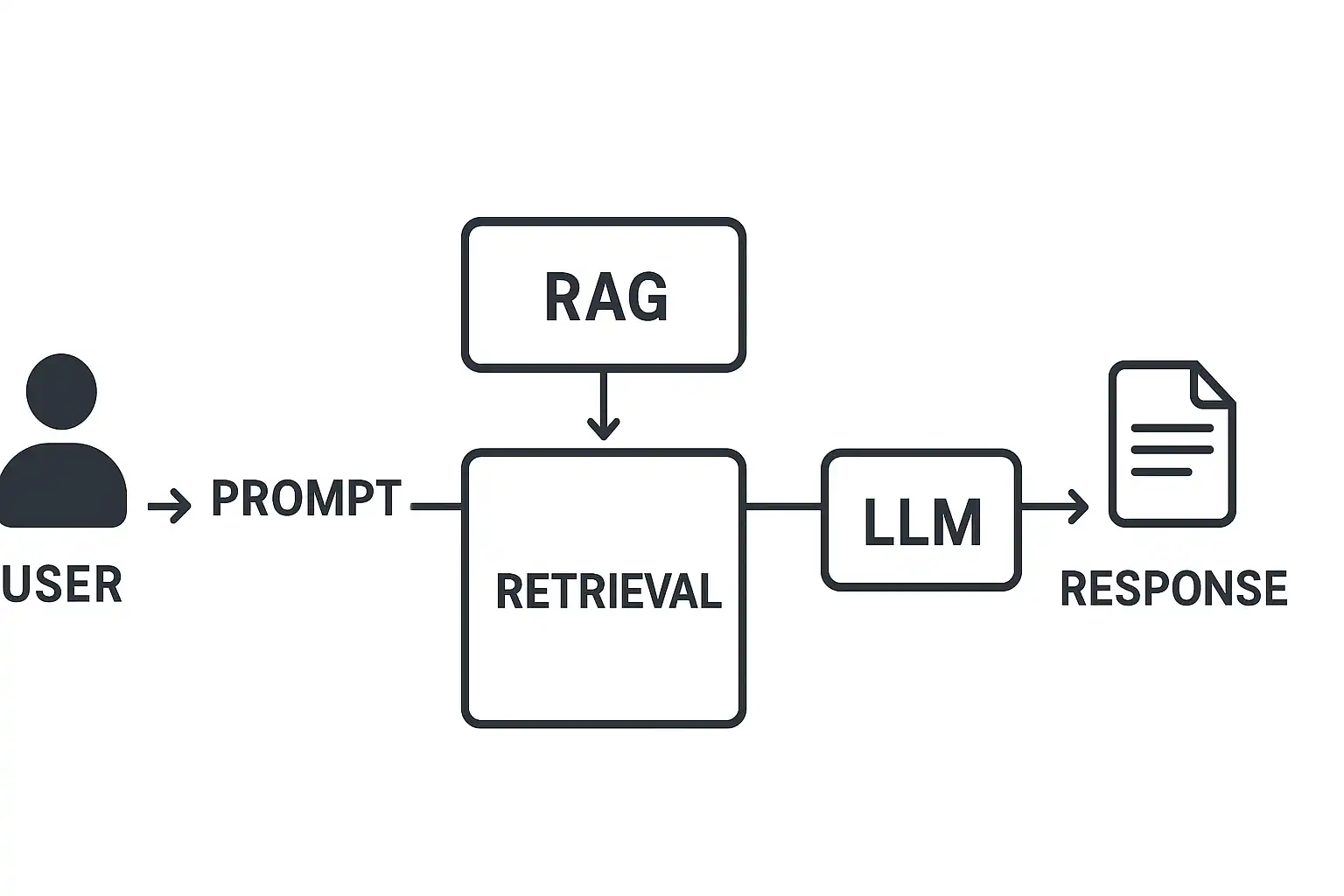

Como o RAG funciona:

- Indexação: documentos são convertidos em vetores e armazenados em um banco de dados vetorial (como FAISS, Milvus ou Pinecone).

- Consulta semântica: o modelo identifica os vetores mais semelhantes ao contexto da pergunta.

- Síntese: as informações recuperadas são incorporadas ao prompt e enviadas ao LLM, que gera uma resposta fundamentada.

Essa integração reduz significativamente as alucinações — respostas inventadas ou imprecisas — e aumenta a confiabilidade dos resultados, principalmente em aplicações corporativas e acadêmicas.

4. Integração entre Engenharia de Prompt, LLM e RAG

A combinação entre Engenharia de Prompt, RAG e LLM é o coração de uma aplicação moderna de IA Generativa. Quando bem implementadas, essas técnicas se complementam, criando sistemas mais inteligentes, explicáveis e úteis.

Fluxo típico de integração:

- O usuário envia uma consulta em linguagem natural.

- O prompt é estruturado conforme padrões de Engenharia de Prompt.

- O sistema RAG busca informações relevantes em uma base vetorial.

- O LLM gera uma resposta contextualizada, combinando conhecimento interno e externo.

- A resposta é retornada com referências e justificativas.

Essa arquitetura é a base de assistentes corporativos inteligentes, ferramentas de pesquisa jurídica, chatbots de suporte técnico e plataformas de aprendizado adaptativo.

Exemplo prático:

Imagine um chatbot de atendimento que utiliza LLM + RAG + Engenharia de Prompt.

Quando o usuário pergunta sobre a política de reembolso de um produto, o sistema busca os documentos internos atualizados, insere o conteúdo relevante no prompt e gera uma resposta precisa, citando a fonte. Assim, elimina ambiguidades e reduz o tempo de suporte.

5. Reduzindo Alucinações em GenAI

As alucinações são o principal obstáculo à adoção de LLMs em larga escala.

Elas ocorrem quando o modelo gera informações incorretas, porém plausíveis. Isso pode comprometer a credibilidade de uma aplicação, principalmente em domínios sensíveis como saúde, direito ou finanças.

Estratégias eficazes para mitigação:

- Contextualização: forneça o máximo de dados relevantes no prompt.

- RAG integrado: conecte o modelo a fontes atualizadas e verificadas.

- Validação automática: use comparadores semânticos para checar consistência.

- Parâmetros ajustados: reduza a temperatura do modelo (0,2–0,5) para limitar a criatividade.

- Feedback iterativo: analise respostas incorretas e reescreva o prompt.

Essas práticas não apenas melhoram a precisão, mas também fortalecem a confiança do usuário — elemento essencial em qualquer sistema de IA.

6. Arquitetura Visual do Sistema (RAG + LLM + Prompt Engineering)

Figura 1 – Fluxo de integração entre RAG, LLM e Engenharia de Prompt.

7. Aplicações Reais da IA Generativa

A união entre LLMs, RAG e Engenharia de Prompt está remodelando setores inteiros.

Principais aplicações:

- Educação: tutores inteligentes que explicam conceitos com base em materiais didáticos.

- Saúde: sistemas que resumem prontuários e sugerem diagnósticos assistidos.

- Negócios: assistentes corporativos treinados com dados internos.

- Desenvolvimento de software: geração de documentação e testes automatizados.

- Marketing e conteúdo: criação de textos alinhados à identidade da marca.

Cada uma dessas áreas se beneficia da capacidade de adaptar a linguagem da IA ao contexto humano — um reflexo direto da Engenharia de Prompt aliada à busca contextual do RAG.

8. O Futuro da IA Generativa

O avanço dos LLMs está apenas começando. A próxima geração de modelos deve incorporar aprendizado contínuo, interpretação multimodal e agentes autônomos capazes de executar tarefas complexas sem supervisão direta.

Entre as tendências mais promissoras, destacam-se:

- Modelos personalizados: ajustados a contextos corporativos específicos.

- Prompt Chains: cadeias de prompts interconectadas que simulam raciocínio avançado.

- Agentes de IA cooperativos: múltiplos modelos colaborando em tempo real.

- Governança de IA: foco em ética, transparência e segurança dos dados.

A Engenharia de Prompt, nesse cenário, deixará de ser apenas uma técnica e se tornará uma competência estratégica para profissionais de todas as áreas que interagem com IA.

9. Conclusão — IA Generativa como Ferramenta de Impacto

A sinergia entre LLMs, Engenharia de Prompt e RAG redefine a forma como criamos e consumimos informação.

Com prompts bem formulados e integração contextual, a IA deixa de ser apenas uma executora de comandos e se transforma em uma parceira cognitiva — capaz de raciocinar, explicar e gerar valor real.

Dominar essas práticas é mais do que acompanhar a evolução tecnológica; é participar ativamente dela.

Afinal, escrever, projetar e orientar a IA é também um ato de transformação — uma forma de construir o futuro com as próprias palavras.

Referências

- Brown, T. et al. (2020). Language Models are Few-Shot Learners. NeurIPS.

- Lewis, P. et al. (2020). Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks. NeurIPS.

- OpenAI (2024). Prompt Engineering Best Practices.

- DeepLearning.AI (2023). ChatGPT Prompt Engineering for Developers.

- Vaswani, A. et al. (2017). Attention is All You Need.