RAG: O Guia Prático da IA Generativa para Conectar LLMs a Dados Privados

A IA Generativa é revolucionária, mas todo dev que tenta criar uma aplicação empresarial encontra a mesma barreira: como fazer um LLM responder sobre dados internos sem "alucinar"? Perguntar ao ChatGPT sobre o último relatório PDF da sua empresa, hoje, é um beco sem saída.

A resposta para conectar LLMs a dados privados não é (necessariamente) o caro e lento fine-tuning. A solução é uma arquitetura elegante e poderosa chamada RAG (Retrieval-Augmented Generation).

Neste guia profundo (+2.000 palavras), vamos dissecar tecnicamente o pipeline completo do RAG. Você aprenderá como implementar essa arquitetura, do "chunking" de documentos à mágica dos "Vector DBs", para construir uma IA Generativa que realmente entende o seu negócio e responde com base em fatos.

O Problema: A "Amnésia Corporativa" da IA Generativa

Para entender por que o RAG é tão vital, precisamos primeiro diagnosticar o problema padrão dos LLMs: eles são gênios com amnésia. Um modelo como o GPT-4 ou o Llama 3 é treinado em um conjunto de dados massivo da internet, mas esse conhecimento é estático e generalista.

Isso cria três problemas fundamentais para qualquer aplicação de IA Generativa no mundo real:

1. O "Corte" de Conhecimento (Knowledge Cut-off) Todo LLM tem uma data de "corte". Se você perguntar sobre um evento de ontem ou sobre o novo produto que sua empresa lançou hoje, ele simplesmente não saberá. Ele está "congelado no tempo".

2. A Falta de Contexto Privado Este é o maior obstáculo. O LLM não leu seus e-mails, não acessou seu banco de dados de clientes ou seus PDFs internos. Para ele, sua empresa não existe. Tentar usar um LLM "puro" para um chatbot de atendimento é impossível.

3. As "Alucinações" (Hallucinations) Uma alucinação é o maior risco da IA Generativa. Quando um LLM não sabe a resposta, ele não diz "eu não sei". Ele inventa uma resposta que parece plausível. Para uma empresa, uma IA que inventa dados financeiros falsos não é só inútil, é perigosa.

Tentar resolver isso enviando seus dados privados via prompt tem um limite óbvio: a janela de contexto. Você não pode colar um PDF de 50 páginas em cada pergunta.

O Conceito: A Batalha de Arquiteturas - RAG vs. Fine-Tuning em LLMs

Quando os desenvolvedores percebem os problemas acima, eles se deparam com uma bifurcação: devo usar RAG ou Fine-Tuning (Ajuste Fino)? A escolha errada aqui custa tempo e muito dinheiro.

O que é Fine-Tuning (Ajuste Fino)? O Fine-Tuning é um processo de retreinamento. Você pega um LLM de base (como o GPT-3.5) e continua seu treinamento com um conjunto de dados menor e específico.

Analogia: É como pegar um médico clínico geral (o LLM base) e colocá-lo em uma residência médica de cardiologia (seus dados). Ele não aprende fatos novos, mas aprende um estilo, um tom e um comportamento especialista.

Quando usar? Ideal para ensinar à IA um tom de voz (ex: "seja sempre sarcástico") ou um formato de saída específico (ex: "sempre gere um JSON").

O que é RAG (Retrieval-Augmented Generation)? O RAG, como vimos, é uma arquitetura. Ele não altera o LLM. Ele "aumenta" o modelo conectando-o a um banco de dados externo (o Vector DB).

Analogia: É como dar ao mesmo médico clínico geral (o LLM base) um tablet com acesso em tempo real ao prontuário do paciente (seus dados). O médico não foi retreinado, mas suas respostas são infinitamente melhores porque ele está consultando a fonte da verdade.

Quando usar? Ideal para aplicações que precisam responder com base em conhecimento factual (PDFs, relatórios, manuais) que muda constantemente.

Comparativo Definitivo: RAG vs. Fine-Tuning

(Aviso: Cole esta parte e depois selecione-a e clique no botão de "Lista com Bolinhas" (Bullet Points) do editor para formatar corretamente!)

Critério: Objetivo Principal

RAG: Injetar conhecimento factual e externo.

Fine-Tuning: Mudar o estilo, tom ou formato de saída.

Critério: Combate à Alucinação

RAG: Alto. A resposta é baseada em contexto real.

Fine-Tuning: Baixo. Pode até aumentar a alucinação.

Critério: Atualização de Dados

RAG: Fácil e em tempo real. Basta atualizar o Vector DB.

Fine-Tuning: Difícil. Requer um novo processo de retreinamento.

Critério: Custo (Computacional)

RAG: Baixo. Requer apenas inferência e um Vector DB.

Fine-Tuning: Alto. Requer GPUs potentes para retreinamento.

Critério: "Citabilidade" da Fonte

RAG: Alta. Você sabe qual "chunk" do PDF gerou a resposta.

Fine-Tuning: Nenhuma. A resposta vem da "memória" do modelo.

Conclusão da Seção: Para 90% dos casos de uso de IA Generativa empresarial—como chatbots internos ou análise de contratos—, o RAG não é apenas a melhor escolha, é a única escolha viável.

Mão na Massa: O Pipeline Detalhado do RAG

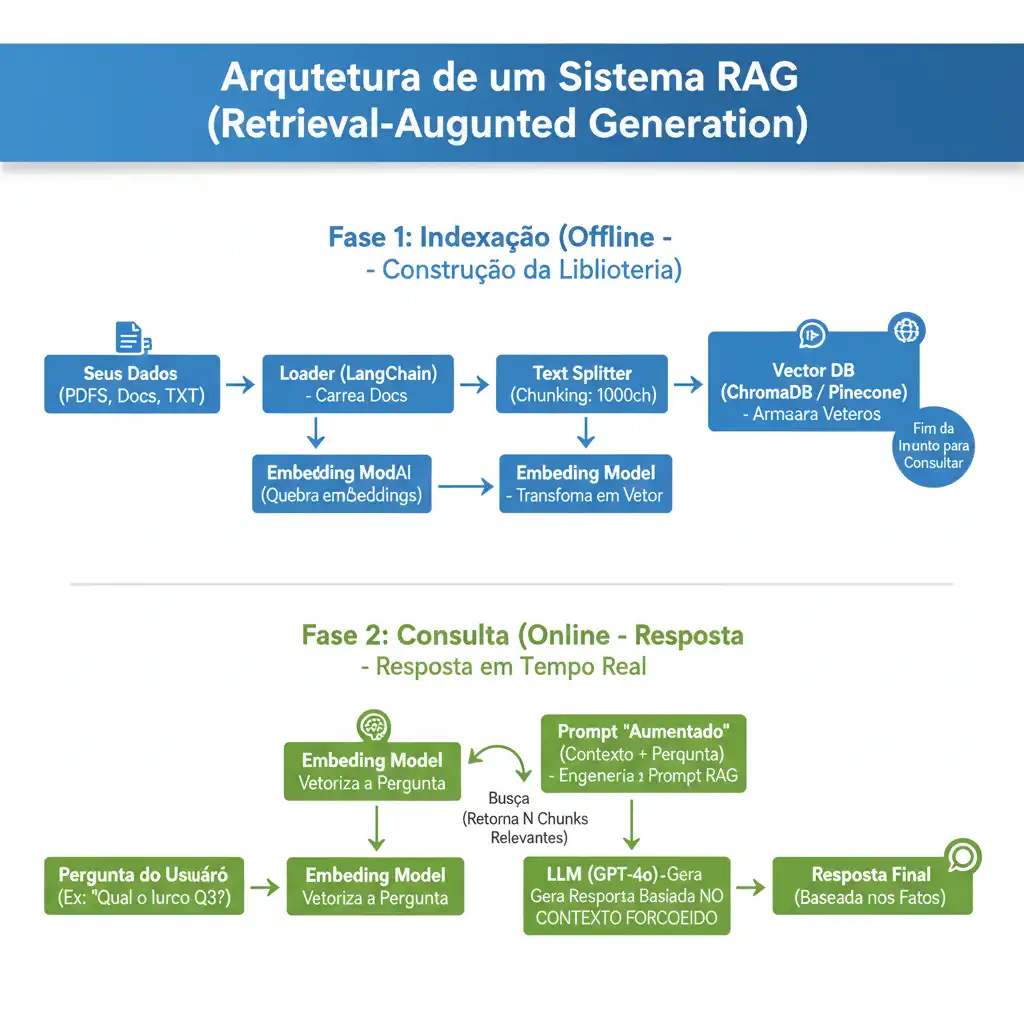

Saímos da teoria e entramos na prática. Um sistema RAG funcional tem duas fases:

Fase 1: Indexação (Offline): O processo de "ensinar" à sua biblioteca o conteúdo dos seus documentos.

Fase 2: Consulta (Online): O processo em tempo real onde o usuário faz uma pergunta e o sistema busca a resposta.

Vamos construir nosso pipeline com Python, LangChain, ChromaDB (para testes) e a API da OpenAI.

Fase 1: A Indexação (A "Biblioteca")

3.1. Ingestão (Load): O Ponto de Partida do seu RAG

Primeiro, precisamos carregar os dados. O LangChain oferece "Loaders" (carregadores) para quase tudo.

Python

# Instale as bibliotecas necessárias:

# pip install langchain langchain_openai chromadb pypdf

from langchain_community.document_loaders import PyPDFLoader

# 1. Carregar o documento

loader = PyPDFLoader("seu-relatorio-interno.pdf")

docs = loader.load()

3.2. Fragmentação (Chunking): A Estratégia Crítica dos LLMs

Este é, talvez, o passo mais importante para um RAG de qualidade. Não podemos enviar um PDF de 50 páginas de uma vez para um LLM; ele não cabe na "janela de contexto". Precisamos "quebrar" (fragmentar) os documentos em pedaços menores, ou "chunks", usando chunk_overlap (sobreposição) para não perder o contexto.

Python

from langchain.text_splitter import RecursiveCharacterTextSplitter

# 2. Fragmentar (Chunking)

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=1000, # Tamanho de cada "chunk" (em caracteres)

chunk_overlap=200 # Sobreposição entre chunks

)

splits = text_splitter.split_documents(docs)

3.3. Embeddings: O "DNA do Significado" para sua IA Generativa

Agora, precisamos transformar esses chunks de texto em vetores—o "DNA do significado" que a máquina entende. Um modelo de "Embedding" transforma texto em uma lista de números (ex: 1536 números) onde textos com significados similares ficam próximos no espaço vetorial.

Python

from langchain_openai import OpenAIEmbeddings

# 3. Criar o modelo de Embedding

# (Configure sua API Key da OpenAI no ambiente)

embedding_model = OpenAIEmbeddings()

3.4. Armazenamento (Store): O Papel dos Vector DBs no RAG

Finalmente, armazenamos esses vetores (embeddings) em um Banco de Dados Vetorial (Vector DB). Um Vector DB é otimizado para busca por similaridade semântica (como "similaridade de cosseno"). Vamos usar o ChromaDB para salvar localmente.

Python

from langchain_community.vectorstores import Chroma

# 4. Armazenar no Vector DB (Indexação)

# Isso irá carregar os 'splits',

# calcular o embedding de cada um,

# e salvar tudo no diretório "meu_vector_db"

vector_store = Chroma.from_documents(

documents=splits,

embedding=embedding_model,

persist_directory="meu_vector_db"

)

Fase 2: A Consulta (A "Prova com Consulta")

Agora que a "biblioteca" está pronta, vamos usá-la.

3.5. Retrieve & Generate: A IA Generativa em Ação

O LangChain orquestra isso com a chain RetrievalQA. Ela faz 3 coisas:

Retrieve: Pega a pergunta do usuário, transforma em vetor, e busca os chunks mais similares no ChromaDB.

Augment: Monta um "super-prompt" para o LLM.

Generate: Envia o prompt para o LLM e obtém a resposta.

O "Super-Prompt" (O Segredo anti-alucinação do RAG): Por baixo dos panos, o RAG usa uma Engenharia de Prompt robusta para forçar o LLM a usar apenas os fatos:

"Use apenas o contexto fornecido abaixo para responder à pergunta. Não use nenhum conhecimento externo. Se a resposta não estiver no contexto, diga 'Não encontrei essa informação nos documentos'.

Contexto: *[...aqui entram os "chunks" recuperados do Vector DB...]

Pergunta: *[...aqui entra a pergunta original do usuário...]

Resposta: "

O Código Final (Juntando Tudo): Veja como é simples usar a "biblioteca" que criamos:

Python

from langchain_openai import ChatOpenAI

from langchain.chains import RetrievalQA

# 1. Carregar o LLM que vai GERAR a resposta

llm = ChatOpenAI(model_name="gpt-4o", temperature=0)

# 2. Carregar o Vector DB que já criamos

vector_store_carregado = Chroma(

persist_directory="meu_vector_db",

embedding_function=embedding_model

)

# 3. Criar a "Chain" de RAG

qa_chain = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff", # "stuff" é o método de "juntar" os chunks

retriever=vector_store_carregado.as_retriever(search_kwargs={"k": 3})

# "k: 3" = me traga os 3 chunks mais relevantes

)

# 4. FAZER A PERGUNTA!

pergunta = "Qual foi o lucro líquido reportado no Q3?"

resposta = qa_chain.invoke(pergunta)

print(resposta['result'])

# Resposta esperada: 'O lucro líquido em Q3 foi de R$10 milhões.'