Segurança e LLMs no Mundo Corporativo

A implementação de Inteligência Artificial no ambiente corporativo se tornou um dos assuntos mais discutidos no mundo da tecnologia. Muitas empresas enxergam a corrida da IA como uma oportunidade promissora para acelerar processos e impulsionar o desenvolvimento organizacional.

No entanto, adotar modelos de linguagem sem o devido planejamento e cuidado pode trazer sérios riscos. Em vez de otimizar resultados, o uso incorreto da IA pode comprometer a segurança dos dados, gerar informações incorretas e até prejudicar a reputação da empresa.

O que fazer?

Implementar medidas de segurança e contar com uma equipe capacitada para gerir o uso da IA pode ser a chave do sucesso — tanto para grandes empresas quanto para pequenos negócios.

Afinal, ninguém quer que uma IA acabe vazando dados sensíveis ou prejudicando a comunicação com o cliente.

Para evitar esse tipo de problema, é fundamental assumir o controle da tecnologia, garantindo que ela nunca opere de forma totalmente autônoma, sem supervisão humana.

A segurança e as boas práticas são essenciais para aumentar a confiabilidade e a eficiência das LLMs no ambiente corporativo.

O papel do RAG na segurança das LLMs

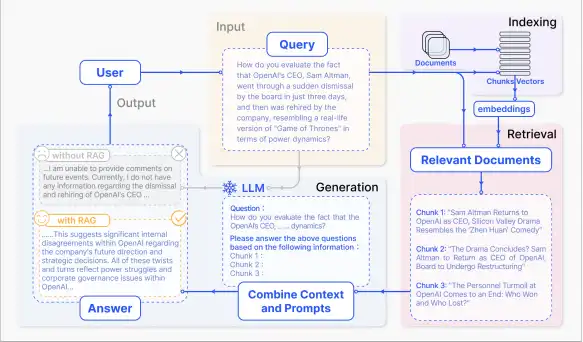

Uma das formas mais eficazes de aumentar a segurança e a confiabilidade de uma LLM é através do uso da técnica RAG (Retrieval-Augmented Generation).

Referência: Paper original sobre RAG

O RAG combina o poder dos modelos de linguagem com fontes de dados externas e confiáveis, evitando que a IA gere informações inventadas ou acesse conteúdos indevidos.

Além de reduzir erros, o RAG permite que a empresa mantenha seus dados sensíveis fora do modelo, fornecendo apenas as informações relevantes no momento da consulta.

Isso significa que o modelo não “aprende” permanentemente com dados internos — uma prática essencial para evitar vazamentos e manter a conformidade com políticas de segurança e LGPD.

Exemplos reais

A empresa JPMorgan Chase implementou um sistema avançado de detecção de fraudes bancárias baseado em RAG, integrando análise em tempo real, cruzamento de dados internos e feeds externos de inteligência.

O resultado foi maior precisão, menos falsos positivos e mais agilidade na revisão, protegendo clientes e a instituição.

Leia mais: JPMorgan - AI Fraud Shield

O banco Bradesco construiu um pipeline corporativo de IA generativa seguro com RAG e arquitetura auditável, implementando guardrails para proteger dados, mitigar alucinações e garantir compliance no ambiente financeiro regulado.

Leia mais: Bradesco - IA generativa segura e auditável

A importância da Engenharia de Prompt

Outra prática fundamental para o uso seguro e eficiente das LLMs é a Engenharia de Prompt.

Ela consiste em formular comandos e perguntas de forma estratégica, garantindo que o modelo produza respostas precisas, seguras e alinhadas aos objetivos da empresa.

Uma boa engenharia de prompt reduz ambiguidades, previne erros de interpretação e assegura que o modelo opere dentro de limites éticos e corporativos definidos.

Em ambientes empresariais, isso representa mais controle, menos riscos e maior eficiência.

Exemplo real

Empresas como a Supero utilizam Engenharia de Prompt em todos os projetos de IA generativa, otimizando assistentes virtuais, relatórios automáticos, atendimento ao cliente e integração de fluxos nos sistemas internos corporativos.

Leia mais: Supero - Engenharia de Prompt para IA corporativa

Checklist de Segurança para LLMs Corporativos

- Defina objetivos claros para o uso da IA na empresa.

- Identifique dados sensíveis e restrinja o acesso dos modelos a essas informações.

- Adote técnicas como RAG para proteger dados internos.

- Realize engenharia de prompt para evitar ambiguidades e garantir respostas alinhadas aos interesses corporativos.

- Implemente supervisão humana contínua sobre os sistemas de IA.

- Treine equipes para operação segura e ética dos modelos de linguagem.

- Teste e monitore o desempenho dos LLMs regularmente.

- Realize auditorias para identificar e corrigir possíveis vazamentos ou falhas.

- Mantenha compliance com normas como a LGPD e diretrizes internas de segurança.

- Documente todos os processos, usos e atualizações dos LLMs.

- Estabeleça políticas claras de acesso, uso e manutenção da IA.

- Revise e atualize constantemente os protocolos de segurança e privacidade.

Adotando essas práticas, sua empresa estará mais preparada para garantir o uso seguro, eficiente e responsável dos modelos de linguagem no ambiente corporativo.