Insights que escalam: com foco em Inteligência Artificial e Azure

- #Azure

Introdução

Vivemos na era dos dados. O volume de informações gerado por pessoas, dispositivos e sistemas cresce em ritmo acelerado. No entanto, dados brutos não têm valor sem análise e inteligência.

É nesse contexto que tecnologias como Python, Inteligência Artificial (IA), Big Data e a plataforma de nuvem Azure entram em cena. Juntas, elas formam uma combinação poderosa para transformar dados em decisões.

Este artigo explora como essas tecnologias atuam juntas para extrair, processar, interpretar e entregar insights relevantes em escala. Mais do que tecnologia, trata-se de aplicar inteligência real ao volume de dados crescente no mundo atual.

Python como base para trabalhar com dados e inteligência artificial

Python é uma das linguagens mais populares do mundo e está no centro das soluções modernas de análise de dados e inteligência artificial. A razão disso está em sua simplicidade, versatilidade e comunidade ativa.

Com Python, é possível realizar desde tarefas simples de análise até a construção de modelos complexos de IA. Tudo isso com poucas linhas de código e muitas bibliotecas eficientes.

Principais vantagens do uso do Python:

- Sintaxe simples e acessível.

- Grande número de bibliotecas para ciência de dados.

- Suporte nativo à IA e machine learning.

- Integração fácil com ambientes em nuvem, como Azure.

Bibliotecas que se destacam:

pandaspara análise de dados tabulares.NumPypara cálculos numéricos.matplotlibeseabornpara visualizações.scikit-learn,TensorFlowePyTorchpara machine learning.

Python não apenas organiza os dados. Ele os prepara para a inteligência.

Big Data com Azure para lidar com volume, velocidade e variedade

Big Data refere-se ao tratamento de conjuntos de dados tão grandes ou complexos que exigem ferramentas e arquiteturas específicas. Azure fornece uma estrutura completa para trabalhar com Big Data de forma escalável.

As principais características do Big Data são conhecidas como os 5 Vs:

- Volume: grande quantidade de dados.

- Velocidade: dados gerados em tempo real.

- Variedade: diferentes formatos e fontes.

- Veracidade: qualidade e confiabilidade.

- Valor: extração de informações úteis.

Serviços Azure voltados ao Big Data:

- Azure Data Lake Storage Gen2: armazenamento otimizado para Big Data.

- Azure Synapse Analytics: análise em larga escala com SQL, Spark e pipelines.

- Azure Data Factory: ingestão e movimentação de dados entre sistemas.

Essas ferramentas permitem coletar, transformar e preparar dados para serem utilizados por modelos de IA e visualizações estratégicas. Tudo isso com segurança, controle de acesso e escalabilidade.

Inteligência Artificial com Python e Azure

Com dados prontos e limpos, entra em cena a Inteligência Artificial. A IA permite extrair padrões, prever comportamentos e automatizar decisões com base em grandes volumes de dados.

Python se destaca como linguagem preferida para IA. Já a Azure fornece todo o suporte necessário para treinar, testar, hospedar e escalar modelos com eficiência.

Aplicações práticas da IA com Python:

- Classificação de sentimentos em textos.

- Previsão de vendas com base em histórico.

- Detecção de fraudes financeiras.

- Recomendação de produtos personalizados.

Serviços Azure que facilitam o uso de IA:

- Azure Machine Learning (Azure ML): construção, treinamento e deploy de modelos de forma automatizada ou com código Python.

- Azure Cognitive Services: APIs prontas para visão, linguagem, fala e decisão.

- Azure OpenAI Service: integração com modelos avançados como ChatGPT.

Com Python, você cria o modelo. Com Azure, você escala para o mundo real.

Arquitetura Azure para Big Data, IA e Python: Fluxo Integrado que Escala

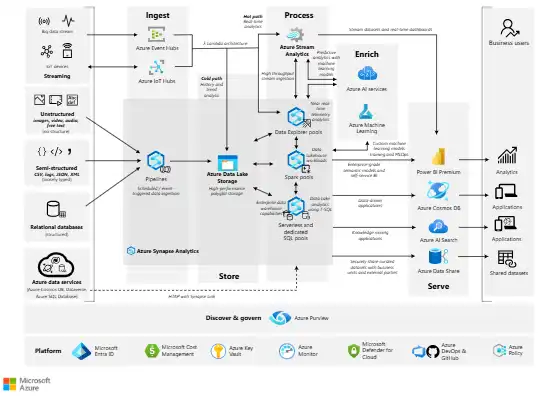

Esta seção apresenta um diagrama que exemplifica a arquitetura recomendada pela Azure para escalar dados, inteligência e automação usando Python, IA e Big Data — tudo nativamente na nuvem.

Principais componentes da arquitetura (conforme o diagrama oficial):

- Fontes de dados: sistemas legados, aplicações web, IoT, APIs etc.

- Ingestão: Azure Data Factory ou Event Hubs para ingestão batch e streaming.

- Armazenamento: Azure Data Lake Storage (camadas raw, curated e gold).

- Processamento Big Data: Azure Synapse Analytics com Spark Pools e PySpark.

- Treinamento IA: Azure Machine Learning para treinamento e testes com bibliotecas Python como scikit‑learn, TensorFlow ou PyTorch.

- Publicação de modelo: Azure ML Endpoint (serviço REST para inferência em tempo real).

- Processamento em tempo real / ações: Azure Stream Analytics ou Azure Functions, acionando lógica com base em previsões.

- Exploração interativa: Azure Synapse Studio (notebooks Python + dashboards internos).

Esse fluxo, todo dentro de Azure, ilustra como escalar desde a coleta dos dados até a entrega de inteligência por meio de IA e automação com Python.

Estudo de Caso: pipeline de análise 100% na Azure com Python, IA e Big Data

Imagine uma empresa do setor financeiro que deseja detectar fraudes em tempo real. Milhões de transações são realizadas diariamente e precisam ser analisadas com agilidade.

Para isso, a empresa decide usar uma solução totalmente baseada em Azure, com IA e Python. A seguir, o pipeline completo dessa solução.

1. Ingestão de dados com Azure Data Factory

- Dados de clientes, transações e dispositivos são coletados.

- Integração com APIs, bancos de dados e arquivos CSV.

- Pipeline de ingestão automatizada alimenta o Data Lake.

2. Armazenamento no Azure Data Lake Storage

- Dados brutos são armazenados de forma segura e escalável.

- Separação por zonas (raw, curated, gold) para organização.

- Controle de acesso baseado em permissões do Azure AD.

3. Processamento com PySpark no Azure Synapse

- Dados brutos são tratados com código Python em Spark Pools.

- Aplicação de filtros, transformações e agregações.

- Os dados prontos são salvos em tabelas otimizadas.

4. Treinamento de modelo de IA com Azure ML

- Dados tratados são usados para treinar modelos de detecção de anomalias.

- Algoritmos como Random Forest e XGBoost são aplicados.

- Testes de acurácia e validação cruzada são executados.

5. Publicação do modelo com Azure ML Endpoint

- O modelo treinado é publicado como endpoint REST.

- Pode ser chamado em tempo real por outras aplicações.

6. Orquestração com Azure Functions

- Funções serverless são disparadas quando novas transações chegam.

- As funções chamam o modelo publicado para classificar transações.

- Casos suspeitos são registrados e enviados para análise.

7. Visualização com Azure Synapse Studio

- Painéis interativos mostram volume de transações, alertas e histórico.

- Dashboards em notebooks Python com gráficos dinâmicos.

- Tudo dentro da própria interface do Synapse.

Essa arquitetura é 100% escalável, segura e automatizada — com base em Python, Big Data, IA e Azure.

Vantagens da solução integrada com Azure, IA, Python e Big Data

Unir essas tecnologias não é apenas tendência. É uma resposta real aos desafios atuais das empresas, pesquisadores e governos. Entre os principais benefícios, estão:

- Escalabilidade total: processa bilhões de registros sem perda de desempenho.

- Automação inteligente: menos intervenção humana, mais agilidade.

- Integração nativa: os serviços Azure conversam entre si com facilidade.

- Rapidez na entrega de valor: do dado bruto ao insight em minutos.

- Flexibilidade com Python: código aberto, personalizável e adaptável.

Casos reais de aplicação ( +usados )

🔹 Setor de saúde

Análise de exames com IA para diagnóstico assistido.

🔹 Varejo

Previsão de demanda e personalização de ofertas.

🔹 Finanças

Detecção de fraudes e avaliação de crédito com modelos preditivos.

🔹 Educação

Análise do desempenho de alunos e recomendações de conteúdo.

🔹 Governo

Análise de políticas públicas com dados abertos e IA preditiva.

Conclusão

Python fornece a linguagem. Big Data oferece a matéria-prima. A IA gera o raciocínio. E a Azure entrega tudo isso com escala, segurança e integração.

Essa união de forças cria um ciclo virtuoso de inteligência aplicada:

Dado → Análise → Modelo → Decisão → Ação.

Profissionais que dominam essa arquitetura têm papel estratégico na transformação digital de qualquer organização. Eles não apenas analisam — eles ampliam o potencial dos dados com inteligência real.