Desenvolvi uma aplicação para "conversar" com meus artigos da DIO

Imagine uma situação onde você gostaria de obter insights de diversos sites de forma simultânea. Esta era a minha inquietação. Para solucionar isto, comecei a planejar uma plataforma onde eu poderia submeter o site e obter algumas informações via LLM. É possível ver o planejamento (Mapa) na Figura 1.

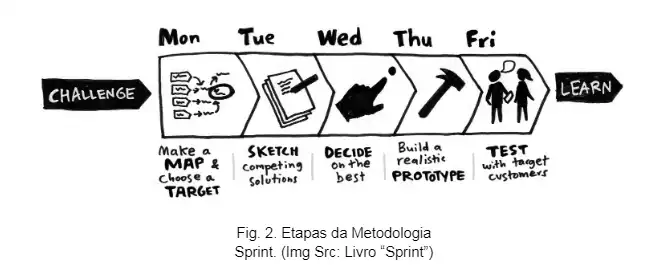

No repositório consta também o processo que uso para modelar as aplicações. O Sprint, ele é constituído de cinco etapas e foi pensado para ser uma adaptação do Design Thinking. Os seus criadores Jake Knapp e J. Zaretsky criaram na época em que trabalhavam no Google. Se tornando um framework principal da empresa para o desenvolvimento de ideias. É possível visualizar o framework na Figura 2.

Em prototipagem eu uso Streamlit para deployment e para UI. Possibilita que eu dedique mais tempo para outras atividades da Engenharia de IA, sendo elas:

- Escolha do modelo (Mistral)

- Parâmetros (Temperatura, etc)

- Flow (Quantidade de Tokens)

- Data (Conteúdo que será analisado pelo LLM)

- Criação do Prompt

- Etc

Na Figura 3 é possível ver a interface final, com os campos planejados no Sprint. É possível notar diferenças e limitações, uma vez que é um trabalho em progresso.

Eu selecionei um dos meus trabalhos na DIO para que ele pudesse extrair as situações mais relevantes. Podemos observar o resultado na Figura 4.

É possível estender para jornais, blogs ou qualquer outra coisa a qual seja possível extrair o texto. No futuro o meu plano é indexar vários sites e obter insights valiosos em relação ao que cada um contém.