A Diretriz G11 e a Transparência em Sistemas de Inteligência Artificial

A Diretriz G11 e a Transparência em Sistemas de Inteligência Artificial

Explicabilidade pós-fato, confiança do usuário e desafios de implementação

Introdução

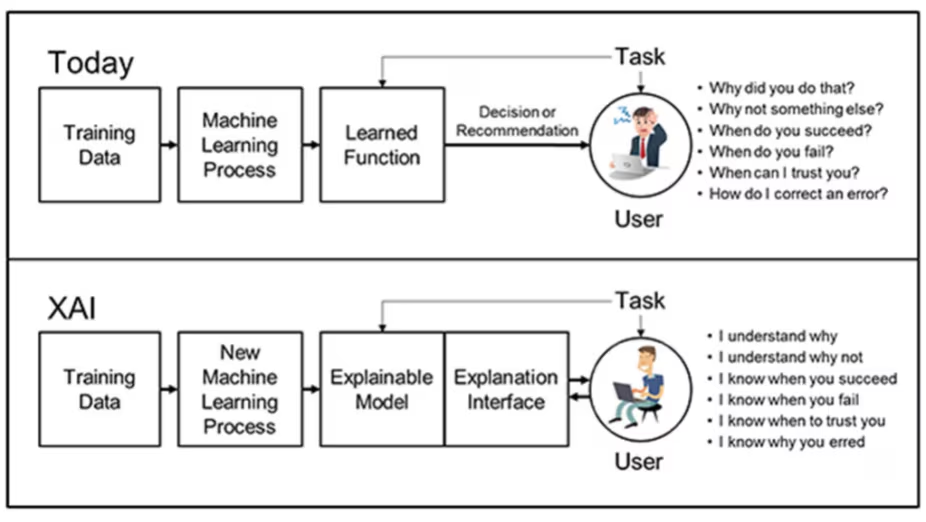

A adoção crescente de sistemas baseados em Inteligência Artificial (IA) em contextos sociais, organizacionais e críticos tem intensificado o debate sobre confiabilidade, responsabilidade e aceitabilidade dessas tecnologias. À medida que sistemas automatizados passam a influenciar decisões relevantes — como recomendações, classificações e priorizações — torna-se essencial que os usuários compreendam não apenas os resultados apresentados, mas também os fundamentos que orientaram o comportamento do sistema (FLORIDI et al., 2018).

Nesse cenário, surgem diretrizes de interação humano–IA com o objetivo de orientar o desenvolvimento de sistemas mais compreensíveis, previsíveis e alinhados às expectativas humanas. Entre essas diretrizes, destaca-se a G11, que trata explicitamente da transparência do sistema, entendida como a capacidade de explicar por que a IA tomou uma determinada decisão (AMERSHI et al., 2019).

A relevância da diretriz G11 torna-se ainda maior quando se considera que muitos sistemas contemporâneos de IA são probabilísticos e não determinísticos. Sem transparência sobre seus processos decisórios, esses sistemas tendem a gerar incerteza, desconfiança e até rejeição por parte dos usuários, comprometendo sua adoção em ambientes reais (RUSSELL; NORVIG, 2021).

O que é a Diretriz G11?

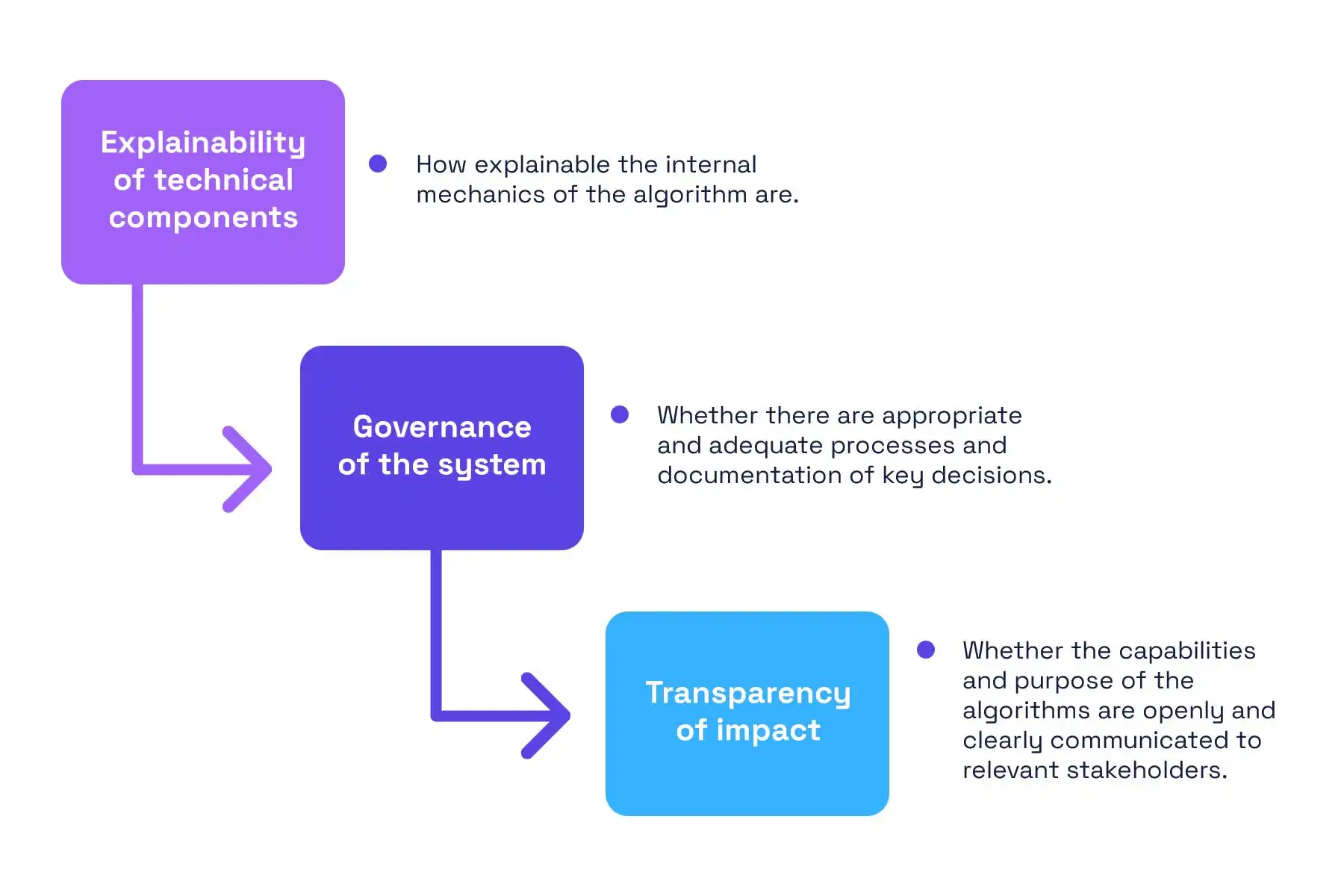

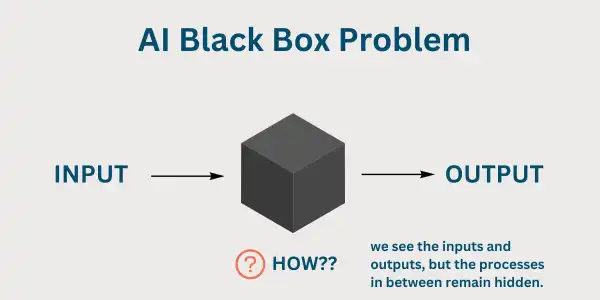

A diretriz G11 está associada à transparência explicativa, ou seja, à capacidade do sistema de tornar claro o motivo de uma ação específica após ela ter ocorrido. Diferentemente de diretrizes que tratam do que o sistema pode fazer ou de quão bem ele executa suas tarefas, a G11 foca no “porquê” de uma decisão concreta (AMERSHI et al., 2019).

Essa abordagem é conhecida como explicação pós-fato (post-hoc explanation). Nela, o sistema não apenas executa uma ação, mas também fornece uma justificativa compreensível para o usuário, mesmo que o funcionamento interno do modelo seja complexo ou opaco, como ocorre em arquiteturas de aprendizado profundo (DOSHI-VELEZ; KIM, 2017).

É importante destacar que transparência, nesse contexto, não significa expor integralmente o modelo matemático ou seus parâmetros internos. O foco está em oferecer explicações adequadas ao contexto de uso e ao perfil do usuário, tornando a decisão inteligível do ponto de vista funcional e conceitual (MILLER, 2019).

Acesso aos critérios de decisão

Um dos pilares da diretriz G11 é permitir que o usuário compreenda quais critérios influenciaram uma decisão automatizada. A transparência exige que o sistema indique os fatores considerados relevantes ao gerar uma recomendação, classificação ou escolha (LIPTON, 2018).

Em aplicativos de navegação, por exemplo, a aplicação da G11 implica informar se uma rota foi escolhida por ser a mais rápida, a mais curta ou a que evita pedágios — e não apenas apresentá-la como a “melhor opção”. O mesmo vale para sistemas de recomendação, nos quais o usuário deve entender se uma sugestão foi baseada em preferências anteriores, comportamento de usuários semelhantes ou tendências recentes (GUIDOTTI et al., 2019).

Ao tornar explícitos os critérios de decisão, o sistema reduz sua opacidade e permite que o usuário avalie criticamente a adequação da recomendação ao seu próprio contexto. Esse processo reduz a sensação de arbitrariedade frequentemente associada a sistemas de IA (RIBEIRO; SINGH; GUESTRIN, 2016).

Redução da incerteza e construção de confiança

A transparência promovida pela diretriz G11 desempenha um papel central na redução da incerteza do usuário. Quando a lógica de decisão não é apresentada de forma clara, recomendações e resultados tendem a ser percebidos como arbitrários, prejudicando a experiência de uso (LEE; SEE, 2004).

A ausência de explicações também pode gerar frustração, especialmente quando o sistema apresenta resultados inesperados ou divergentes das expectativas humanas. Nesse contexto, a explicação pós-fato funciona como um mecanismo de alinhamento cognitivo, permitindo que o usuário compreenda a racionalidade do sistema mesmo quando discorda da decisão tomada (HOFF; BASHIR, 2015).

Com isso, a diretriz G11 contribui diretamente para a construção e manutenção da confiança. Ao entender os motivos de uma decisão, o usuário passa a perceber o sistema como mais previsível e confiável, favorecendo uma relação de cooperação entre humano e IA (LEE; SEE, 2004).

Desafios e limitações na implementação da G11

Apesar de sua importância, a diretriz G11 está entre as mais frequentemente negligenciadas em produtos de IA atualmente disponíveis. Embora exista uma vasta produção acadêmica sobre explicabilidade e inteligibilidade, muitos sistemas ainda não oferecem explicações adequadas — ou sequer qualquer justificativa — para suas ações (BURKART; HIEBERT, 2021).

Um dos principais desafios está na complexidade dos modelos subjacentes, especialmente aqueles baseados em aprendizado profundo, cujos processos decisórios envolvem representações estatísticas de alta dimensionalidade difíceis de traduzir em linguagem acessível ao usuário final (GUIDOTTI et al., 2019).

Além disso, existem limitações práticas relacionadas à interface, ao desempenho e ao custo de desenvolvimento. Na prática, soluções comerciais frequentemente priorizam eficiência operacional e velocidade de entrega em detrimento da transparência explicativa, comprometendo a aderência à diretriz G11 (LIPTON, 2018).

A importância da G11 em sistemas probabilísticos

Sistemas modernos de IA operam predominantemente de forma probabilística, o que implica variabilidade e imprevisibilidade nos resultados apresentados. Essa característica decorre da própria natureza estatística dos modelos de aprendizado profundo, treinados a partir de grandes volumes de dados (GOODFELLOW; BENGIO; COURVILLE, 2016).

Nesse contexto, a diretriz G11 torna-se essencial para mitigar os impactos negativos dessa imprevisibilidade sobre a experiência do usuário. A explicação pós-fato permite que decisões automatizadas sejam interpretadas como resultado de critérios identificáveis, e não como ações arbitrárias ou inexplicáveis (DOSHI-VELEZ; KIM, 2017).

Esse processo é comparável a mecanismos de revisão em contextos regulados, nos quais não basta tomar uma decisão: é necessário justificar os critérios que a sustentam, garantindo legitimidade e aceitação social (FLORIDI et al., 2018).

Considerações finais

A diretriz G11 estabelece a transparência explicativa como um princípio fundamental para o desenvolvimento de sistemas de Inteligência Artificial centrados no usuário. Ao tornar claros os motivos das decisões automatizadas, a G11 contribui para a redução da incerteza, o fortalecimento da confiança e a ampliação da aceitabilidade das tecnologias baseadas em IA (AMERSHI et al., 2019).

Embora sua implementação envolva desafios técnicos e conceituais significativos, a adoção efetiva da diretriz G11 é indispensável em um cenário no qual sistemas probabilísticos assumem papéis cada vez mais relevantes em decisões cotidianas e organizacionais (RUSSELL; NORVIG, 2021).

Avanços futuros em explicabilidade, design de interação humano–IA e governança algorítmica tendem a ser decisivos para consolidar a transparência como elemento estruturante de sistemas de IA confiáveis, responsáveis e socialmente aceitáveis (FLORIDI et al., 2018).

Referências

AMERSHI, Saleema et al. Guidelines for Human-AI Interaction. Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems. ACM, 2019.

BURKART, Nadia; HIEBERT, Marco. A survey on the explainability of supervised machine learning. Journal of Artificial Intelligence Research, v. 70, p. 245–317, 2021.

DOSHI-VELEZ, Finale; KIM, Been. Towards a rigorous science of interpretable machine learning. arXiv:1702.08608, 2017.

FLORIDI, Luciano et al. AI4People—An ethical framework for a good AI society. Minds and Machines, 2018.

GOODFELLOW, Ian; BENGIO, Yoshua; COURVILLE, Aaron. Deep Learning. MIT Press, 2016.

GUIDOTTI, Riccardo et al. A survey of methods for explaining black box models. ACM Computing Surveys, 2019.

HOFF, Kevin A.; BASHIR, Masooda. Trust in automation. Human Factors, 2015.

LEE, John D.; SEE, Katrina A. Trust in automation. Human Factors, 2004.

LIPTON, Zachary C. The mythos of model interpretability. ACM Queue, 2018.

MILLER, Tim. Explanation in artificial intelligence. Artificial Intelligence, 2019.

RIBEIRO, Marco Túlio; SINGH, Sameer; GUESTRIN, Carlos. Why should I trust you? ACM SIGKDD, 2016.

RUSSELL, Stuart; NORVIG, Peter. Artificial Intelligence: A Modern Approach. Pearson, 2021.