Arquitetura de IA para Sistemas Críticos: Orquestração Especializada vs. Monolito Cognitivo

- #IA Agents

- #Arquitetura de Sistemas

- #IA Generativa

- #Inteligência Artificial (IA)

Programo desde os 14 anos. Hoje, aos 43, olho para trás e vejo três décadas de frameworks, linguagens e "balas de prata" que prometiam resolver tudo. Vi o surgimento e queda de paradigmas: da programação estruturada à orientação a objetos, dos monólitos aos microsserviços, das arquiteturas SOA ao serverless. Cada onda trazia sua promessa de complexidade zero e produtividade infinita.

Agora, vivemos a era da IA Generativa. E vejo muitos caindo em uma armadilha que considero tecnicamente ingênua: presumir que um único "Super Modelo" de IA um LLM com centenas de bilhões ou trilhões de parâmetros vai, sozinho, entregar sistemas complexos, legados e críticos, como os que desenvolvi na MTM ou que vemos em instituições financeiras, saúde e infraestrutura.

Minha experiência com IA não começou com o ChatGPT. Quando implementei os primeiros agentes cognitivos com IBM Watson (ainda na era pré-transformers), eu já discutia os fundamentos teóricos de IA Generativa com amigos acadêmicos. A conclusão técnica a que cheguei, que hoje aplico na arquitetura do que chamo de Sistema Operacional Agentico, baseia-se em um paradoxo fundamental validado pela literatura mais recente.

O Paradoxo do LLM Generalista: Contexto Infinito, Precisão Finita

Os grandes modelos de linguagem (LLMs) como GPT-4, Claude ou Gemini são treinados em trilhões de tokens. Esse volume massivo os torna, paradoxalmente, generalistas demais e específicos demais ao mesmo tempo. Eles "sabem" sobre Python e microsserviços, mas desconhecem as idiossincrasias do seu legado, suas constraints de compliance e os trade-offs históricos do seu código.

O Problema da Degradação Contextual (Lost in the Middle)

A crença de que janelas de contexto de 128k ou 200k tokens resolvem o problema de memória é refutada pela engenharia fundamental dos Transformers. A pesquisa seminal de Liu et al. (2023) demonstra empiricamente uma curva de desempenho em forma de "U": a precisão na recuperação de informações é alta no início e no fim do prompt, mas sofre degradação severa no meio.

Não se trata apenas de "esquecimento", mas de uma limitação da atenção quadrática ($O(N^2)$). Em sistemas críticos, injetar 50 manuais técnicos no contexto aumenta a probabilidade de alucinação sobre regras de segurança que fiquem "enterradas" na metade do vetor de atenção. Mesmo modelos recentes, apesar da capacidade nominal de memória, continuam sujeitos a essa cegueira atencional quando a densidade de raciocínio exigida é alta.

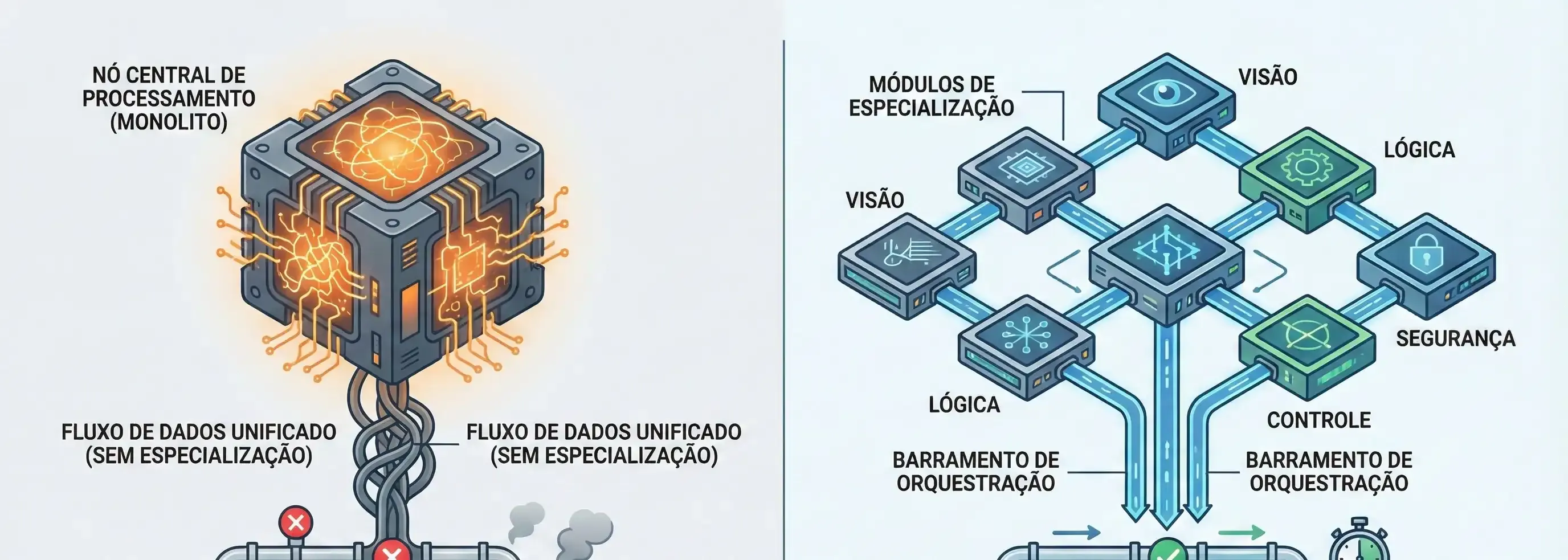

A Teoria da Linha de Montagem Cognitiva: Arquitetura Multi-Agente Heterogênea

Minha tese, fundamentada na literatura clássica de Sistemas Multiagente (MAS), propõe que a robustez nasce da distribuição, não da centralização. Wooldridge (2009) define agentes não como meras subrotinas, mas como entidades autônomas e pró-ativas. Stone & Veloso (2000) vão além, destacando que sistemas heterogêneos (agentes com estruturas diferentes) são superiores em evitar falhas sistêmicas correlacionadas.

Princípio 1: Decomposição Modular e Heterogeneidade

Em vez de um monólito propenso a falhas, decompomos a cognição em agentes especializados que operam com contextos curtos e densos (< 8k tokens), evitando o problema "Lost in the Middle":

- Agente de Análise de Requisitos: Transforma linguagem natural em especificações formais.

- Agente de Arquitetura: Avalia trade-offs (CAP theorem, consistência).

- Agente de Segurança (Adversarial): Treinado especificamente em threat modeling e OWASP. Baseado no princípio de heterogeneidade, este agente deve ter um "prompt de sistema" e até uma base de conhecimento (RAG) distinta dos agentes de desenvolvimento, atuando como um "Red Team" interno.

Princípio 2: Especialização via Fine-Tuning e RAG Contextual

A especialização reduz o espaço de busca e a alucinação.

- Fine-Tuning Supervisionado: Um Agente SQL treinado apenas em dialetos específicos de bancos de dados e planos de execução performáticos não tentará inventar APIs REST.

- RAG Cirúrgico: Em vez de injetar toda a documentação, usamos busca vetorial para trazer apenas os 3-5 exemplos mais relevantes (similaridade cosseno > 0.85). Isso mantém a "memória de trabalho" do agente na zona de alta performance da curva de atenção de Liu et al.

Princípio 3: Colaboração Orquestrada (Workflow DAG)

A interação segue um Grafo Acíclico Dirigido (DAG), garantindo determinismo no fluxo de dados:

Requisitos → Arquitetura → → Integração → Testes → Segurança → Deploy

O Fator Humano: HITL como Princípio de Segurança

Aqui entra o ponto crítico, baseado em Human-AI Teaming. A automação total em sistemas críticos é perigosa devido ao viés de automação.

Parasuraman & Manzey (2010) definem a "complacência de automação" como o desvio de atenção do operador quando o sistema é percebido como altamente confiável. Se o Monólito acerta 99% das vezes, o humano para de verificar. Quando o erro de 1% ocorre (o "Lost in the Middle"), a catástrofe acontece.

No modelo de Sistema Operacional Agêntico, o humano atua como "Arquiteto Sênior" validando Gates específicos. Isso cria o atrito cognitivo necessário para manter o operador engajado e atento.

Fronteiras de Erro Parsimoniosas

Bansal et al. (2019) demonstram que humanos colaboram melhor com IAs cujos erros são previsíveis (parsimoniosos).

- Monólito: Falha de forma estocástica e imprevisível dependendo da posição do texto no prompt. O humano não sabe quando confiar.

- Agentes Especializados: Têm fronteiras de erro claras. O humano sabe que o "Agente de Frontend" não entende de "Indexação de Banco de Dados". Isso permite a construção de Modelos Mentais robustos, onde o humano sabe exatamente onde deve intervir.

Implementação Técnica: Arquitetura de Referência

Stack Tecnológica:

- Orquestração: Temporal.io / Apache Airflow (garantia de estado).

- Agentes: Abstrações via LangChain/LlamaIndex sobre modelos de 7B-13B (LLaMA 3, Mistral) fine-tuned.

- Memória: Vector DB (Pinecone/Weaviate) particionado por domínio de agente.

- Feedback: Interface HITL com captura de Reinforcement Learning from Human Feedback (RLHF) para calibração contínua.

Exemplo de Agente Especializado:

Conclusão: O Futuro é Híbrido

A resposta para software robusto não é um modelo maior. É uma arquitetura híbrida de Sistemas Multiagente Heterogêneos. Ao orquestrar especialistas, respeitamos os limites cognitivos da máquina (atenção quadrática) e potencializamos a capacidade cognitiva humana (julgamento contextual), evitando as armadilhas da complacência.

É assim que construímos o futuro: não com uma "caixa preta mágica", mas com engenharia de sistemas sóbria e validada.

Referências Técnicas

- Liu, N. F. et al. (2023). "Lost in the Middle: How Language Models Use Long Contexts". TACL. (Valida a degradação de performance em janelas de contexto longas).

- Wooldridge, M. (2009). "An Introduction to MultiAgent Systems". Wiley. (Fundamenta a autonomia e orquestração de agentes).

- Stone, P. & Veloso, M. (2000). "Multiagent Systems: A Survey from a Machine Learning Perspective". Autonomous Robots. (Valida a vantagem da heterogeneidade em sistemas complexos).

- Parasuraman, R. & Manzey, D. (2010). "Complacency and Bias in Human Use of Automation". Human Factors. (Explica os riscos psicológicos da automação opaca).

- Bansal, G. et al. (2019)."Beyond Accuracy: The Role of Mental Models in Human-AI Team Performance". AAAI. (Define a importância da previsibilidade dos erros para a confiança humana).

Escrito por um engenheiro de software que acredita que a verdadeira inovação não está em confiar cegamente na tecnologia, mas em arquitetá-la com sabedoria.