Data Warehouse na Prática: Como Estruturei um DW com MySQL e ETL Agendado

📊 Você já pensou em implementar um Data Warehouse, mas achou que seria necessário um investimento enorme em infraestrutura?

Hoje vou mostrar como é possível criar uma solução eficiente mesmo em cenários com baixo volume de dados, utilizando ferramentas simples e estratégias inteligentes.

________________________________________

✅ O que é um Data Warehouse e por que ele é importante?

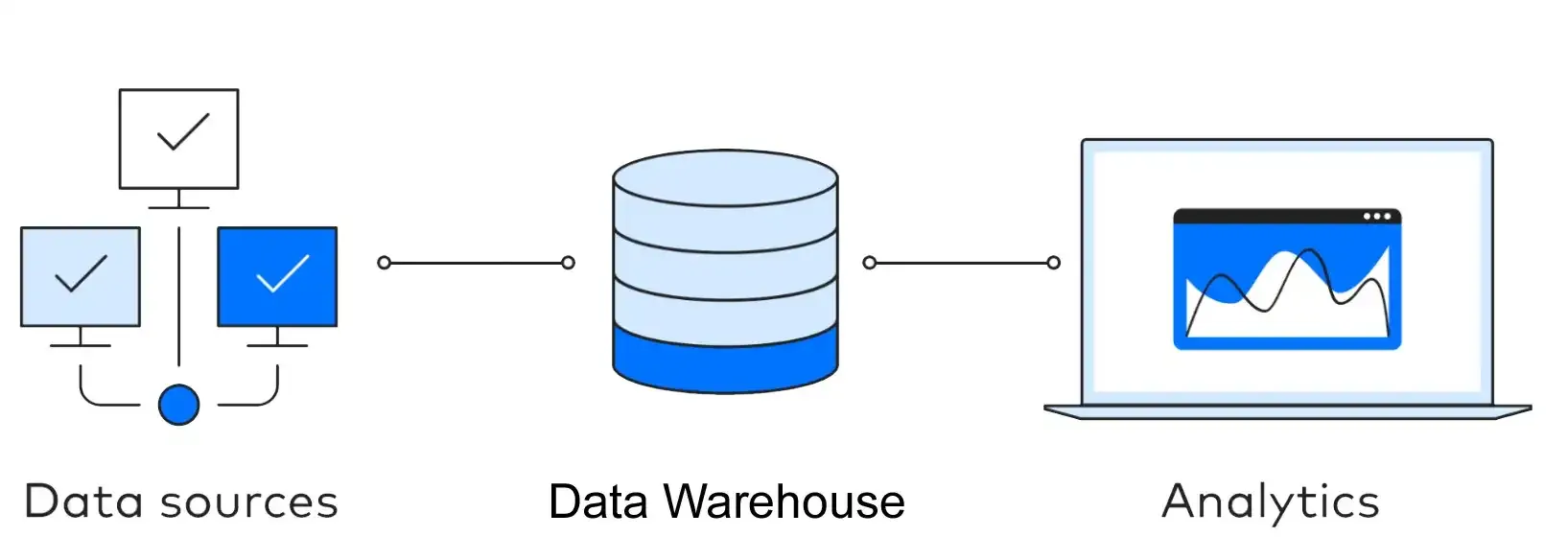

Um Data Warehouse (DW) é um repositório centralizado que armazena dados históricos integrados de várias fontes. Ele é orientado a análise (OLAP), ajudando empresas a transformar dados em insights para decisões estratégicas.

Ao contrário dos bancos transacionais (OLTP), que são voltados para operações do dia a dia, o DW é otimizado para consultas analíticas, agregações e geração de relatórios.

________________________________________

🏗 Etapas de Desenvolvimento de um Data Warehouse

O desenvolvimento segue um processo estruturado, geralmente baseado na metodologia Kimball (bottom-up) ou Inmon (top-down). As principais etapas são:

1. Levantamento de Requisitos

o Definição das métricas e indicadores (KPIs).

o Identificação das fontes de dados.

2. Modelagem do DW

o Escolha da arquitetura: Star Schema (Estrela), Snowflake Schema (Floco de Neve) ou Data Vault.

o Definição de tabelas fato e dimensões.

3. Definição da Arquitetura e Ferramentas

o Escolha do banco de dados, ferramentas de ETL e camada de visualização.

4. Extração, Transformação e Carga (ETL)

o Extract: Captura dos dados das fontes.

o Transform: Padronização, limpeza e integração.

o Load: Inserção no DW.

5. Criação de Camadas

o Staging Area: Área temporária para dados brutos.

o ODS (Operational Data Store): Dados integrados, mas ainda detalhados.

o DW Principal: Dados agregados e estruturados.

o Data Marts: Subconjuntos por área (financeiro, marketing, etc.).

6. Implementação da Governança e Segurança

o Controle de acessos, políticas de backup e compliance.

7. Testes e Validação

o Testes de integridade, performance e consistência.

8. Disponibilização para BI e Analytics

o Conexão com ferramentas como Power BI, Tableau, Looker, etc.

________________________________________

🗂 Etapas de Preenchimento (Carga de Dados)

• Full Load: Primeira carga completa de dados.

• Incremental Load: Atualizações periódicas (dados novos ou alterados).

• CDC (Change Data Capture) → Detecção de mudanças em tempo real.

________________________________________

🔍 Tipos de Data Warehouse

Existem diferentes abordagens:

• Enterprise Data Warehouse (EDW): Abrange toda a organização.

• Operational Data Store (ODS): Armazena dados quase em tempo real, usados para relatórios operacionais.

• Data Marts: Focados em áreas específicas (marketing, vendas, RH).

• Cloud Data Warehouse: Serviços totalmente gerenciados em nuvem (BigQuery, Redshift, Synapse).

________________________________________

✅ Vantagens

• Integração de dados de múltiplas fontes.

• Histórico consolidado para análises.

• Suporte a decisões estratégicas.

• Alta performance para consultas analíticas.

• Escalabilidade (principalmente em soluções em nuvem).

________________________________________

❌ Desvantagens

• Alto custo inicial (infraestrutura, licenciamento, equipe).

• Tempo de implementação relativamente longo.

• Complexidade na manutenção e governança.

• Não ideal para consultas em tempo real (salvo arquiteturas híbridas).

________________________________________

🛢 Quais bancos de dados permitem a criação de DW?

• Relacionais tradicionais:

o Oracle Database

o Microsoft SQL Server

o MySQL / PostgreSQL → Ótimo para projetos menores

• Especializados em DW:

o Teradata

o SAP BW

• Em nuvem (Cloud DW):

o AWS (Amazon Web Services)

Amazon Redshift → Data Warehouse totalmente gerenciado.

AWS Glue → ETL Serverless.

Amazon S3 → Data Lake para integração.

Athena → Consultas SQL diretamente sobre dados no S3.

o Google Cloud Platform (GCP)

BigQuery → Data Warehouse totalmente gerenciado.

Dataflow → ETL baseado em Apache Beam.

Cloud Storage → Data Lake.

Looker → Visualização e BI.

o Azure (Microsoft)

Azure Synapse Analytics → DW + integração com ferramentas analíticas.

Azure Data Factory → ETL/ELT.

Azure Blob Storage / Data Lake Storage → Armazenamento bruto.

________________________________________

⚡ E na prática? Meu exemplo com MySQL

No meu caso, eu precisava de um DW para análise de indicadores, mas estava limitado pelo contexto:

✔ Mesmo servidor do Banco Transacional

✔ Baixo volume de dados (comparado a grandes corporações)

✔ Sem orçamento para uma solução cloud gerenciada

💡 O que eu fiz?

• Modelei o DW no próprio MySQL, separando um schema dedicado.

• Desenvolvi os processos ETL diretamente em SQL, utilizando scripts para:

o Extrair os dados do banco transacional.

o Transformar (limpeza, agregações, normalizações).

o Carregar no modelo dimensional.

• Configurei a carga diária na madrugada, garantindo que os relatórios estejam sempre atualizados.

Esse processo simples atende muito bem à necessidade atual, e a escalabilidade poderá ser repensada futuramente (migrando para BigQuery, Redshift ou Synapse, por exemplo).

________________________________________

Conclusão

Nem sempre é necessário começar com soluções caras e complexas. Um DW bem planejado, mesmo em MySQL, pode transformar dados brutos em insights valiosos para o negócio.

🔗 E você, já implementou um Data Warehouse? Fez algo parecido? Compartilha sua experiência nos comentários!