Python na Análise de Dados: Coleta de Informação com Ghost in the Shell

Introdução

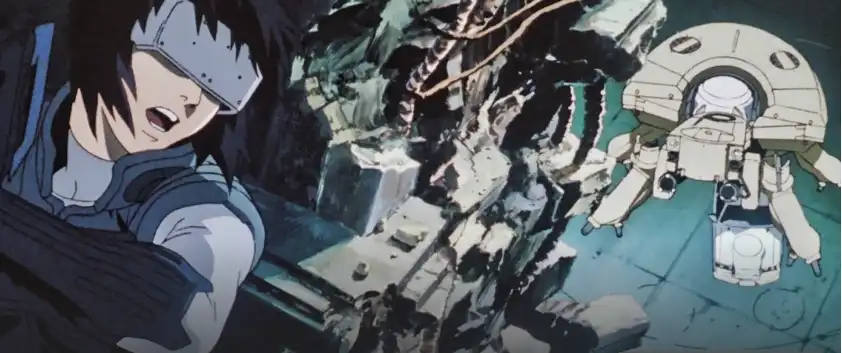

Em um mundo cada vez mais conectado, a análise de dados é a chave para entender e prever comportamentos, otimizar sistemas e acelerar decisões. Python, com sua simplicidade e poder, é a linguagem que lidera essa revolução informacional. Agora imagine isso dentro do universo cibernético de Ghost in the Shell, onde redes, inteligências artificiais e humanos estão fundidos em um ecossistema digital hiperconectado.

Neste artigo, vamos explorar conceitos avançados de coleta e tratamento de grandes volumes de dados usando Python — tudo isso guiado por analogias inspiradas na protagonista Major Motoko Kusanagi e o universo tecnológico da Seção 9.

Coleta de Dados com APIs RESTful: Invadindo Sistemas como a Major Kusanagi

Conceito Técnico:

APIs são a forma mais direta e limpa de coletar dados estruturados na web. Com autenticação via tokens e headers personalizados, acessamos serviços em tempo real para obter dados confiáveis e atualizados.

- Requisições GET com headers personalizados

- Manipulação de JSONs como dicionários

- Paginação de resultados

Analogia Ghost in the Shell:

Quando a Major acessa sistemas cibernéticos sigilosos, ela precisa de credenciais de acesso, decodifica protocolos de comunicação e interage com inteligências artificiais. A API é esse "canal seguro" de transmissão, e Python é o invasor autorizado.

Código de exemplo:

import requests

url = 'https://api.securedata.com/v1/data'

headers = {

'Authorization': 'Bearer SEU_TOKEN_DE_ACESSO',

'Accept': 'application/json'

}

response = requests.get(url, headers=headers)

if response.status_code == 200:

dados = response.json()

for item in dados['results']:

print(f"ID: {item['id']} - Valor: {item['value']}")

else:

print(f"Falha no acesso: Código {response.status_code}")

Tratamento eficiente de grandes volumes de dados

Conceito Técnico:

Trabalhar com big data exige técnicas para otimizar o uso de memória e processamento:

- Leitura em blocos (chunking)

- Tipagem otimizada (

category,float32,int32) - Filtros e seleção de colunas no momento da leitura

- Processamento iterativo

Analogia Ghost in the Shell:

Major Kusanagi não escaneia todos os dados de uma rede de uma vez. Ela utiliza filtros, processadores paralelos e sistemas de triagem. Nós fazemos o mesmo com Python.

Código de exemplo:

import pandas as pd

chunk_size = 50000

colunas = ['timestamp', 'ip_origem', 'evento']

for chunk in pd.read_csv('log_eventos_rede.csv',

usecols=colunas,

chunksize=chunk_size,

dtype={'ip_origem': 'category'}):

eventos_criticos = chunk[chunk['evento'] == 'violacao_de_sistema']

print(f"Eventos críticos neste lote: {len(eventos_criticos)}")

Manipulação com Pandas + Dask: distribuindo a carga como em um sistema cibernético

Conceito Técnico:

Quando o volume de dados ultrapassa a RAM, usamos ferramentas como o Dask para dividir o processamento em nós, com execução paralela e em disco.

- Dask DataFrame é similar ao Pandas, mas distribuído

- Permite operações em datasets que não cabem na memória

Analogia Ghost in the Shell:

A Seção 9 nunca opera sozinha. Vários agentes e sistemas autônomos dividem as tarefas em tempo real. Dask faz isso: é o time da Major em forma de código.

Código de exemplo:

import dask.dataframe as dd

# Carrega o arquivo de forma distribuída

ddf = dd.read_csv('grande_base_de_dados.csv')

# Conta a quantidade de ocorrências por tipo

resumo = ddf['evento'].value_counts().compute()

print(resumo)

Exportação otimizada: salvando com inteligência

Conceito Técnico:

Salvar os dados no formato correto é essencial para eficiência:

- Use Parquet ou Feather para alta performance

- CSV é legível, mas lento para leitura/gravação

- Evite salvar dados brutos sem tratamento

Analogia Ghost in the Shell:

No universo do anime, dados brutos podem ser corrompidos ou expor falhas de segurança. A Major sempre extrai, trata e compacta informações com segurança e inteligência. Python deve fazer o mesmo.

Código de exemplo:

df_filtrado = ddf[ddf['evento'] == 'acesso_nao_autorizado'].compute()

# Salvando como Parquet (compactado, binário e eficiente)

df_filtrado.to_parquet('eventos_filtrados.parquet')

Conclusão

Python na análise de dados é aquilo que a Major é para a Seção 9, uma interface poderosa, flexível e conectada com todos os sistemas. Em um mundo cada vez mais orientado por dados, saber coletar, tratar e transformar grandes volumes com eficiência é uma habilidade essencial.

E quando usamos analogias para entender esses processos, conectamos código e criatividade — tal como a fusão entre homem e máquina em Ghost in the Shell.

Se você é um agente da análise de dados, que tal começar a pensar como a Major?

Referencias

📎 Python – A base de tudo

A documentação oficial do Python é como o manual da Seção 9 do Ghost in the Shell: completa, direta e cheia de detalhes ocultos. Se você quer entender como as estruturas de linguagem funcionam de verdade, esse é o ponto de partida.

📎 Pandas – Manipulando dados como se fossem memórias

Se o Python é o cérebro, o Pandas é o córtex de análise. A documentação traz desde tutoriais básicos até guias avançados sobre DataFrames, filtros complexos e importações em massa.

📎 Dask – Computação paralela para dados gigantes

Imagine distribuir sua mente em vários corpos como a Major Motoko. Dask permite isso com dados: processar em paralelo, dividir em blocos e manter performance mesmo fora da memória.

📎 APIs REST – Comunicação entre sistemas, estilo Ghost

Para entender como as aplicações trocam dados no ciberespaço. Essencial se você vai consumir dados externos ou integrar modelos com outras ferramentas.

📎 Requests – Buscando dados de forma elegante

Como uma coleta de campo silenciosa e precisa. Essa biblioteca permite interações HTTP com autenticação, headers e payloads — como se você estivesse hackeando um banco de dados corporativo.

📎 PySpark – Quando os dados ficam realmente grandes

A arma pesada para quem está lidando com Big Data de verdade. A documentação do PySpark mostra como lidar com dados distribuídos em clusters, sem perder o controle do código.

📎 Parquet + Apache Arrow – Armazenar dados com eficiência cibernética

O formato ideal quando você quer transportar dados de forma compacta e rápida — como criptografar memórias para transmitir por redes seguras.

📎 Pipelines com Dask – Caso real e aplicado (SciPy 2022)

Apresentação real de como aplicar Dask em cenários grandes, paralelos e realistas. Serve como exemplo prático de tudo que foi citado no artigo.

🚀 Pronta para dominar o universo dos dados com a astúcia da Major Motoko?

Não deixe seus projetos navegarem no escuro — transforme informação em ação, aprenda técnicas avançadas de análise e dê o próximo passo na sua carreira!

Gostou do artigo? Deixe seu comentário! Quero saber sua opinião, dúvidas e insights para juntos avançarmos na jornada dos dados.